新智元报道

编辑:编辑部 HYj

AI 巨头的芯片之争,谷歌微软目前分列一二。而 xAI 作为新入局者,正迅速崛起。这场竞争中,谁会成为最后赢家?

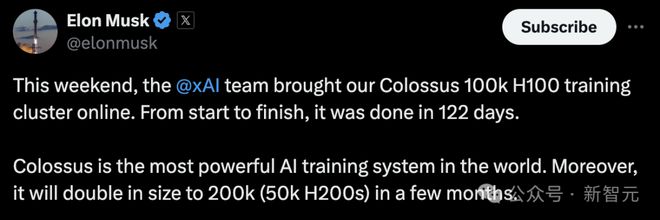

今年,马斯克用全球最大 AI 超算 Colossus 轰动了整个世界。

这台超算配备了 10 万张英伟达 H100/H200 显卡,并预计未来即将扩展到 20 万张。

自此,AI 巨头们倍感压力,数据中心大战火上浇油。巨头们纷纷酝酿着各自的建造计划。

最近,LessWrong 网站上发表了一篇博客,根据公开数据对英伟达芯片的产量、各个 AI 巨头的 GPU/TPU 数量进行了估计,并展望了芯片的未来。

截止目前,世界五大科技公司的 2024 年拥有的算力,以及 2025 年的预测:

微软有 75 万-90 万块等效 H100,明年预计达到 250 万-310 万谷歌有 100 万-150 万块等效 H100,明年预计达到 350 万-420 万 Meta 有 55 万-65 万块等效 H100,明年预计达到 190 万-250 万亚马逊有 25 万-40 万块等效 H100,明年预计达到 130 万-160 万 xAI 有 10 万块等效 H100,明年预计达到 55 万-100 万

芯片数量估算总结

可见,他们都在紧锣密鼓地布局自己的算力版图,开展下一代更先进模型的训练。

谷歌 Gemini 2.0 预计在本月正式上线。此前,马斯克也曾透露,Grok 3 也会在年底亮相,具体时间仍旧未知。

他表示,在法律问题数据集上完成训练后,下一代 Grok 3 将是一个强大的私人律师,能全天候提供服务。

为了追赶劲敌,OpenAI o2 模型据称也在训练中了。

这一切训练的开展,都离不开 GPU/TPU。

英伟达稳坐 GPU 霸主,25 年或暴销 700 万块

毋庸置疑,英伟达早已跃升为数据中心 GPU 的最大生产商。

11 月 21 日,英伟达发布的 2025 财年第三季度财报预计,2024 自然年的数据中心收入将达 1100 亿美元,比 2023 年的 420 亿美元增长了一倍多,2025 年有望突破 1730 亿美元。

收入主力,那便是 GPU 了。

据估计,2025 年英伟达销量为 650 万至 700 万块 GPU,几乎全是最新的 Hopper 和 Blackwell 系列。

根据生产比例和产量预期,其中约包括 200 万块 Hopper,500 万块 Blackwell。

今年产量:500 万块 H100

那么,2024 年英伟达实际产量是多少?目前,关于这一数据来源较少,有些甚至还对不上。

不过,有估算称 2024 年第四季度将生产约 150 万块 Hopper GPU。不过这包括一些性能较低的 H20 芯片,因此是一个上限值。

根据季度间数据中心收入比例推测,全年生产总量可能上限为 500 万块——这是基于每块 H100 等效芯片收入约 2 万美元的假设,而这个单价似乎偏低;如果使用更合理的 2.5 万美元计算,实际产量应该在 400 万块左右。

这一数据与年初估计的 150 万至 200 万块 H100 生产量存在差异。目前尚不清楚这一差异是否可以归因于 H100 与 H200 的区别、产能扩大或其他因素。

但由于这一估算与收入数据不一致,选择使用更高的数字作为参考。

此前的产量

为了评估目前以及未来谁拥有最多的计算资源,2023 年之前的数据对整体格局的影响有限。

这主要是因为 GPU 性能本身的提升,以及从英伟达的销售数据来看,产量已经实现了大幅增长。

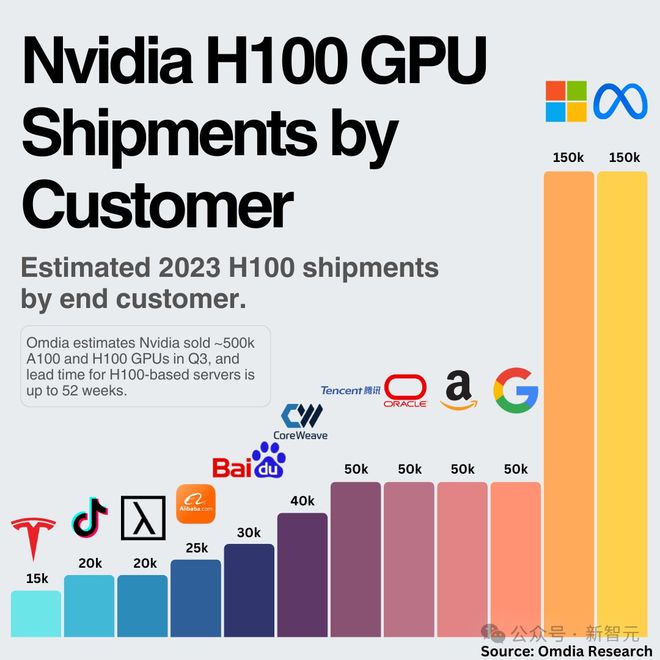

根据估算,微软和 Meta 在 2023 年各自获得了约 15 万块 H100 GPU。结合英伟达的数据中心收入,2023 年 H100 及同等级产品的总产量很可能在 100 万块左右。

五大科技巨头,等效 H100 预测

截止 2024 年底,微软、Meta、谷歌、亚马逊、xAI 将拥有多少块等效 H100?2025 年他们又将扩展到多少块 GPU/TPU?

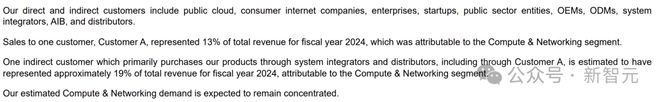

从季度报告(10-Q)和年度报告(10-K)中可以看出,英伟达的客户分为「直接客户」和「间接客户」。

其中,46% 的收入都是来自直接客户,包括像 SMC、HPE、戴尔这样的系统集成商。

他们通过采购 GPU,然后组装成服务器,提供给间接客户使用。

间接客户覆盖的范围就非常广泛,比如公有云服务提供商、互联网消费类公司、企业用户、公共部门机构和创业公司都属于这一范畴。

更直白讲,微软、Meta、谷歌、亚马逊、xAI 都是「间接客户」(关于他们的拥有 GPU 相关信息披露相对宽松,但可信度可能较低)。

2024 年财年报告中,英伟达披露了,约 19% 的总收入来自通过系统集成商和分销商采购产品的间接客户。

根据交易规定,他们必须披露收入占比超过 10% 的客户信息。那么,英伟达的这个数据透露了什么?

要么是,第二大客户规模只有第一大客户的一半,要么是这些数据存在测量误差。

这其中,最大的客户可能是谁?

从现有信息来看,最有可能的候选者是微软。

微软、Meta

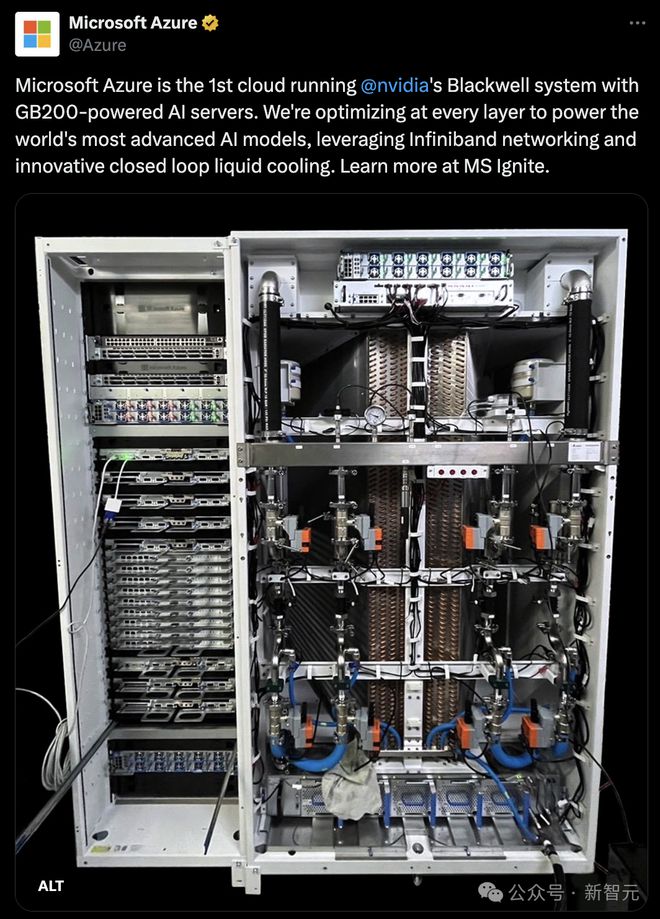

微软很可能就是英伟达这两年的最大客户,这一判断基于以下几个因素:

首先,微软拥有全球最大的公有云服务平台之一;其次,它是 OpenAI 的主要算力供应商;再者,与谷歌、亚马逊不同,微软没有大规模部署自己的定制芯片;最后,微软似乎与英伟达建立了特殊的合作关系——他们是首个获得 Blackwell GPU 的公司。

今年 10 月,微软 Azure 已经开始测试 32 个 GB200 服务器的机架。

2024 年微软的收入占比数据没有 2023 年那么精确,英伟达第二季度财报(10-Q)中提到上半年为 13%,第三季度仅「超过 10%」。

这表明,微软在英伟达销售中的份额较 2023 年有所降低。

另有彭博统计,微软占英伟达收入 15%,其次是 Meta 占 13%,亚马逊占6%,谷歌约占6%(不过资料中并未明确指出这些数据具体对应哪些年份)。

去年来自 Omdia 研究统计,2023 年底 Meta、微软各有 15 万块 H100,亚马逊、谷歌和甲骨文各 5 万块,这一数据与彭博数据更为吻合。

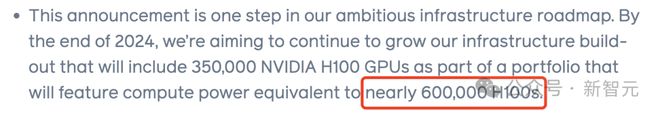

不过,Meta 曾发文宣称,到 2024 年底将拥有相当于 60 万块 H100 算力。据称这包括 35 万块 H100,剩余部分很可能是 H200,以及少量将在最后一个季度交付的 Blackwell 芯片。

如果假设这 60 万的数字准确无误,并结合收入占比进行推算,便可以更准确地估计微软的可用算力。

微软预计将比 Meta 高出 25% 到 50%,也就是相当于 75 万—90 万块等效 H100 算力。

谷歌、亚马逊

仅从英伟达收入的贡献来看,亚马逊、谷歌无疑是落后于微软 Meta。然而,这两家公司的情况有着显著差异。

谷歌已经拥有大量自研的定制 TPU,这是内部工作负载的主要计算芯片。

去年 12 月,谷歌推出了下一代迄今为止最强大的 AI 加速器 TPU v5p。

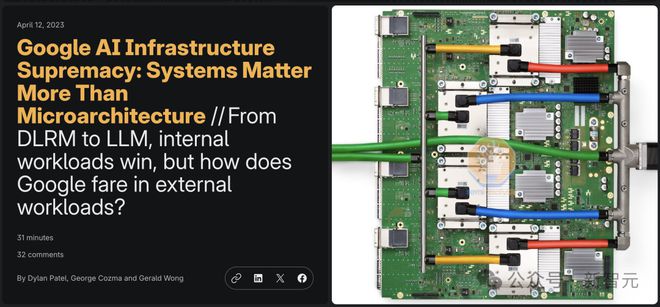

Semianalysis 在 2023 年底一篇报道中指出,谷歌是唯一一家拥有出色自研芯片的公司。

谷歌在低成本、高性能且可靠的大规模 AI 部署方面的能力几乎无人能及,是全球算力最丰富的企业。

而且,谷歌在基础设施上的投入,只会越来越多。2024 年第三季度财报估计,AI 支出为 130 亿美元,「大部分」用在搭建技术基础设施,其中其中 60% 是服务器(GPU/TPU)。

大部分或许意味着 70-110 亿美元,其中在 TPU/GPU 服务器上预估耗资 45-70 亿美元。

按照 TPU 对 GPU 支出2:1 的估算,并保守假设 TPU 的每美元性能与微软的 GPU 支出相当,预计到 2024 年底谷歌将拥有相当于 100 万到 150 万块等效 H100 算力。

相比之下,亚马逊内部 AI 工作负载规模很可能小得多。

他们持有相当数量的英伟达芯片,主要是为了满足通过其云平台提供的外部 GPU 需求,尤其是为 Anthropic 提供算力需求。

毕竟,亚马逊和微软一样,都是金主爸爸,负责为 OpenAI 劲敌提供充足算力。

另一方面,亚马逊虽也有自研的 Trainium 和 Inferentia 芯片,但他们在这方面的起步比谷歌的 TPU 晚得多。

这些芯片似乎远落后于业界最先进水平,他们甚至提供高达 1.1 亿美元的免费额度来吸引用户尝试,这表明目前的市场接受度并不理想。

不过,今年年中,亚马逊定制芯片似乎出现了的转机。

在 2024 年第三季度财报电话会议上,CEO Andy Jassy 在谈到 Trainium2 时表示,这些芯片获得了巨大的市场兴趣,我们已多次与制造合作伙伴协商,大幅提高原定的生产计划。

Semianalysis 报道指出,「根据我们已知数据,微软和谷歌于 2024 年在 AI 基础设施上的投资计划,大幅领先亚马逊部署的算力」。

这些芯片换算成等效 H100 并不明确,关于 Trainium/Trainium2 芯片的具体数量也难以获得,仅知道在上述免费额度计划中提供了 4 万块。

xAI

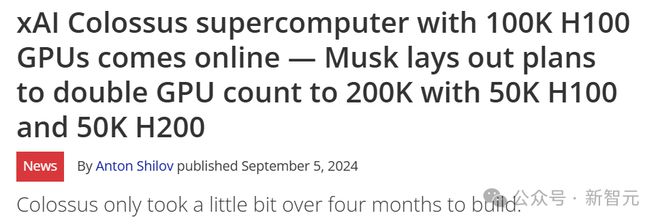

今年,xAI 在基础设施搭建中,最为标志性事件便是——122 天建成了 10 万块 H100 组成的世界最大超算。

而且,这一规模还在不断扩展中。马斯克预告了未来将扩展到 20 万块由 H100/H200 组成的超算。

据称,xAI 超算目前似乎在站点供电方面遇到了一些问题。

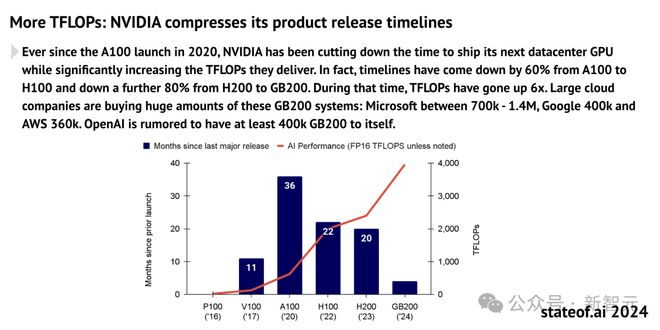

2025 年 Blackwell 芯片预测

最新 2024 AI 现状报告对 Blackwell 采购量进行了估算:

大型云计算公司正在大规模采购 GB200 系统:微软介于 70 万到 140 万块之间,谷歌 40 万块,AWS 36 万块。据传 OpenAI 独自拥有至少 40 万块 GB200。

如果将微软 GB200 预估值设为 100 万块,那么谷歌、AWS 这些数字与它们在英伟达采购中,相对于微软的比例是相符的。

这也使得微软占英伟达总收入的 12%,与 2024 年其在英伟达收入份额的小幅下降趋势一致。

该报告虽然没有给出 Meta 的具体估计数字,但 Meta 预计明年人工智能相关基础设施支出将显著加速,这表明其在英伟达支出中将继续保持高份额。

lesswrong 预计在 2025 年,Meta 的支出规模将维持在微软支出的约 80% 水平。

虽然没有提及 xAI,但马斯克宣称,将在 2025 年夏天部署一个有 30 万块 Blackwell 芯片的运算集群。

虑到马斯克一贯的夸张风格,更为合理的一个估计是,到 2025 年底他们可能实际拥有 20 万—40 万块芯片。

那么,一块 B200 相当于多少块 H100?这个问题对于评估算力增长至关重要。

就训练而言,性能预计飙升(截至 2024 年 11 月)2.2 倍。英伟达发布当天,给出的数据称,两个 B200 组成的 GB200,其性能是 H100 的 7 倍,训练速度是 H100 的 4 倍。

对于谷歌,假设英伟达芯片继续占其总边际计算能力的三分之一。对于亚马逊,这一比例假定为 75%。

值得注意的是,仍有大量 H100 和 GB200 芯片未被计入上述统计中。

有些是未达到英伟达收入报告阈值的机构,还有些是像甲骨文这样的云服务提供商和其他中小型云服务提供商可能持有相当数量的芯片。

此外,也包括一些英伟达重要的非美国客户。

在全面了解各家手握多少 GPU/TPU 算力之后,下一个问题是,这些算力将用在哪?

巨头们训练模型用了多少算力?

以上都讨论的是关于各个 AI 巨头总计算能力的推测,但许多人可能更关心最新前沿模型的训练使用了多少计算资源。

以下将讨论 OpenAI、谷歌、Anthropic、Meta 和 xAI 的情况。

但由于这些公司要么是非上市企业,要么规模巨大无需披露具体成本明细(比如谷歌,AI 训练成本目前只是其庞大业务的一小部分),因此以下分析带有一定的推测性。

OpenAI 和 Anthropic

2024 年 OpenAI 的训练成本预计达 30 亿美元,推理成本为 40 亿美元。

据称,微软向 OpenAI 提供了 40 万块 GB200 GPU,用于支持其训练。这超越了 AWS 整体的 GB200 容量,使 OpenAI 的训练能力远超 Anthropic。

另一方面,Anthropic 2024 年预计亏损约 20 亿美元,而收入仅为几亿美元。

考虑到 Anthropic 的收入主要来自 API 服务且应该带来正毛利,且推理成本应该相对较低,这意味着 20 亿美元中,大部分都用于模型训练。

保守估计其训练成本为 15 亿美元,这大约是 OpenAI 的一半,但并不妨碍其在前沿模型上的竞争力。

这种差异也是可以理解的。Anthropic 的主要云提供商是资源相对有限的 AWS,AWS 的资源通常少于为 OpenAI 提供算力支持的微软。这可能限制了 Anthropic 的能力。

谷歌和 Meta

谷歌的 Gemini Ultra 1.0 模型使用了约为 GPT-4 的 2.5 倍的计算资源,发布时间却晚了 9 个月。其所用的计算资源比 Meta 的最新 Llama 模型高 25%。

尽管谷歌可能拥有比其他公司更多的计算能力,但作为云服务巨头,它面临着更多样的算力需求。与专注于模型训练的 Anthropic 或 OpenAI 不同,谷歌和 Meta 都需要支持大量其他内部工作负载,如社交媒体产品的推荐算法等。

Llama 3 所用计算资源比 Gemini 少,且发布时间晚 8 个月,这表明 Meta 分配给前沿模型的资源相较 OpenAI 和谷歌更少。

xAI

据报道,xAI 使用了 2 万块 H100 训练 Grok 2,并计划用 10 万块 H100 训练 Grok 3。

作为参考,GPT-4 据称使用 2.5 万块 A100 进行了 90-100 天的训练。

考虑到 H100 的性能约为 A100 的 2.25 倍,Grok 2 的训练计算量约为 GPT-4 的两倍,而 Grok 3 则预计达到其 5 倍,处于计算资源利用的前沿水平。

此外,xAI 并非完全依赖于自有芯片资源,部分资源来源于租赁——据估算,他们从 Oracle 云平台租用了 1.6 万块 H100。

如果 xAI 分配给训练的计算资源比例接近 OpenAI 或 Anthropic,推测其训练规模可能与 Anthropic 相当,但低于 OpenAI 和谷歌的水平。

参考资料: