新智元报道

编辑:编辑部 HYZ

谷歌开发者暗示,我们直接进入 ASI 的可能性,正在逐月增加!Ilya 早就看到了这一点,因为扩展测试时计算的成功,证明目前的路径能够到达 ASI。与此同时,AI 学会自我改进、取代人类研究员的未来似乎也愈发逼近,到时再拔网线来得及吗?

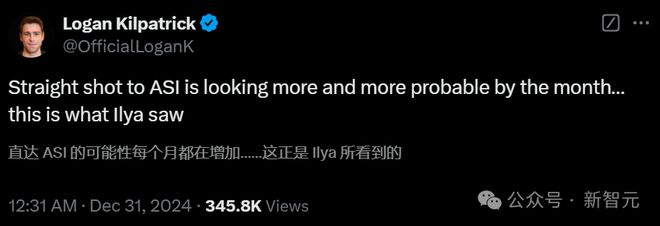

2024 年最后一天,谷歌开发者大佬 Logan Klipatrick 的一个预测,如同扔下了一枚重磅炸弹——

我们直接进入 ASI 的可能性,正在逐月逼近。

而这,就是 Ilya 所看到的。

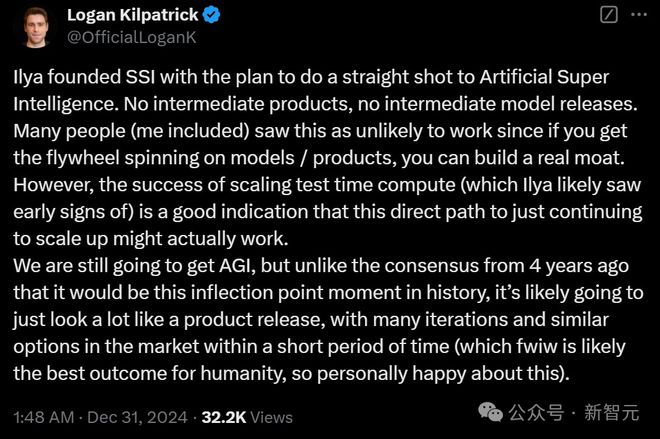

Klipatrick 分析道,Ilya 创立了 SSI,计划直接向 ASI 迈进,没有中间产品,没有中间模型。

曾经,许多人(包括 Klipatrick 本人在内)都觉得这种方法不可能起作用,因为如果通过模型和产品启动飞轮效应,就能建立真正的护城河。

然而,扩展测试时计算的成功表明,这种持续直接扩大规模的路径实际上可能是可行的。

这一点的早期迹象,可能已经被 Ilya 看到了!

如今,我们仍会迎来 AGI,但 4 年前大家普遍认为它会成为一个历史性的转折点,但如今 AGI 的诞生可能更像是一次普通的产品发布,而在短期内,市场上会涌现出许多迭代和类似的选择。

这,可能是对人类最好的结果。

有人做出梗图,表示 Ilya 看到的,就是整个地球都会被太阳能电池板和数据中心覆盖

OpenAI 研究员 Stephen McAleer 称,今天在诺伊谷见到了 Ilya,瞬间感到一股 AGI 诞生的激动涌上心头。

扩展测试时计算,就是 ASI 秘诀?

的确,扩展测试时计算的巨大作用,最近一再被各位学者强调。

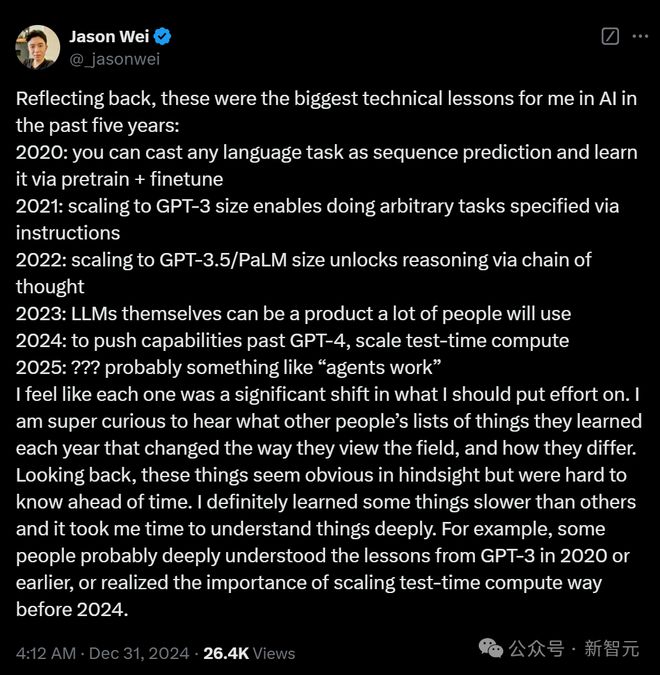

OpenAI 研究员 Jason Wei 总结了过去五年,自己在 AI 方面最大的技术教训。

在他看来,每一个教训,都让自己对于「该在哪里分配精力」发生了重大转变。回想起来,这些教训事后看都是显而易见的,但在事前就很难知晓。

其中,2024 年的教训,就是「扩展测试时计算」。

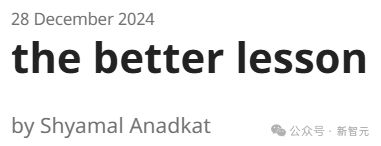

另一位 OpenAI 研究员 Shyamal 就特意发出长文「更好的教训」,强调不要低估延长 LLM 思考时间的作用!

Shyamal 强调,我们仍然低估了仅仅通过给 LLM 更多的思考时间,就能得到的东西。

比如 AlphaGo 的进步,就并非来自复杂的手工设计功能,而是来自简单方法的规模化,在推理中应用大规模搜索,以及集成深度强化学习。

正如 AI 领域「苦涩的教训」所揭示的,最重要的往往就是 scaling 已证明有效的方法。

其中的简单洞见就是,深度学习(与适当的规模扩展结合)往往好于更精巧的方法。

我们需要的不是复杂的架构,而是更多的算力、数据,以及让模型能思考更长时间、更好地与环境交互的方法。

最近 AI 能力的最新框架——聊天机器人、推理器、AI 智能体、组织,都反映了整个行业的发展进程。

从与人对话的简单界面开始,聊天机器人开始发展为推理器,更多工具集成后,它们就演变为了智能体。随后,它们形成了组织——并行工作的分布式智能网络。

在这个过程中,AGI 从一个模型转变为一个系统,一个能大规模协调、写作和执行的系统。

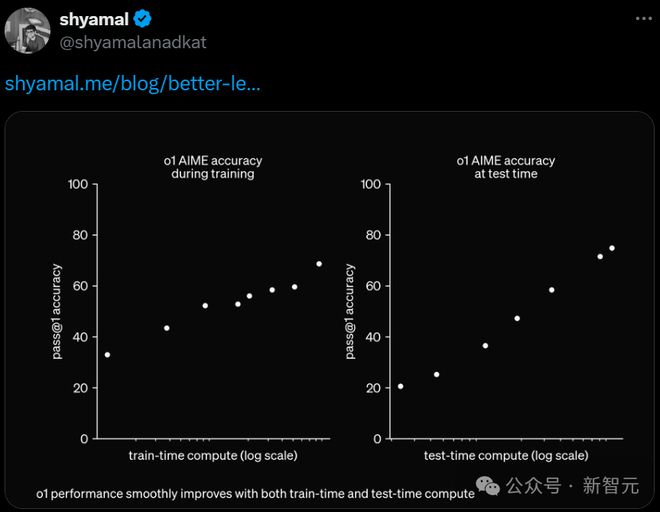

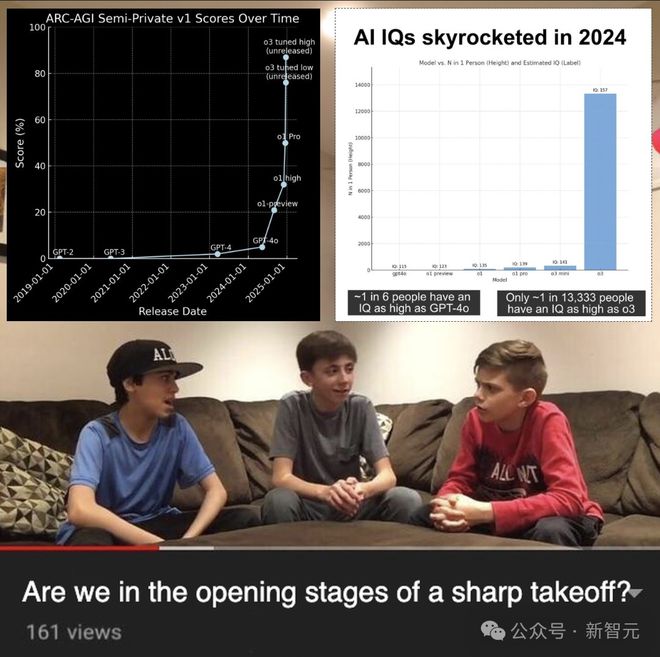

最能体现这一进展的,莫过于 OpenAI 的 o1 了。

o1 在 Codeforces 中排名第 89%,在美国数学邀请赛(AIME)中跻身前 500 名

它在解决问题时会运用 CoT,通过强化学习不断完善思维链,将复杂问题分解为可管理的步骤,在需要时转向新的方法。这种迭代过程中提升了它的推理能力,凸显出思考更长时间及适应性思考的系统的潜力。

而在企业中,这种转变也是类似的。

今天的模型只是总结文档、进行推理,在明天,它们就会成为强大的内部顾问,处理复杂代码、审查合同、协同整个工作流。这是一种全新的「测试时计算」。

所有这些进展都基于一个关键洞见:智能不仅仅局限于生物大脑。它是一种我们可以设计和扩展的物理特性。

深度学习确实行之有效。我们学会了将沙子熔化成硅,然后将硅排列成能存储和处理信息的芯片。现在我们已经教会这些芯片如何思考它们所包含的信息。

我们正在进入一个智能可按需获取、规模化,并通过谨慎约束和对齐来引导的时代。

如果允许这些系统更深入地思考并始终与人类价值观保持一致,我们才刚刚开始挖掘它们的潜力。

人类在历史上一直做的事情,就是不断造出东西,然后造出能大规模建造这些东西、使其有用的工具。

那,AGI 怎么办?

有人说,我们直接奔着 ASI 去了,别再惦记 AGI 了。

不过,在 ASI 之前,科技公司大佬们就 AGI 还有很多话要说。他们纷纷对 AGI 发展时间线做出了预测。

奥特曼一直以来都对 AGI 持乐观态度。他认为,2025 年可能就是节点,但未做出明确的承诺。

OpenAI 对 AGI 的定义

Anthropic CEO Dario Amodei 虽然对 AGI 这一概念本身持谨慎态度,但根据当前 AI 发展趋势,他预计 AGI 将在 2026-2027 年实现。

xAI CEO 马斯克预测也更为大胆,他表示最迟到 2026 年就能实现 AGI。

Meta AI 首席科学家 Yann LeCun 表示,如果当前研发计划顺利,人类水平的 AI 可能会在5-6 年内问世。

而 DeepMind CEO Demis Hassabis 给出了更为保守的预测,他认为距离真正的 AGI 还需约 10 年时间,且在此过程中仍需2-3 项重大技术突破。

与此同时,谷歌也在 AGI 时间预测上表现得十分谨慎,未给出具体的时间表。

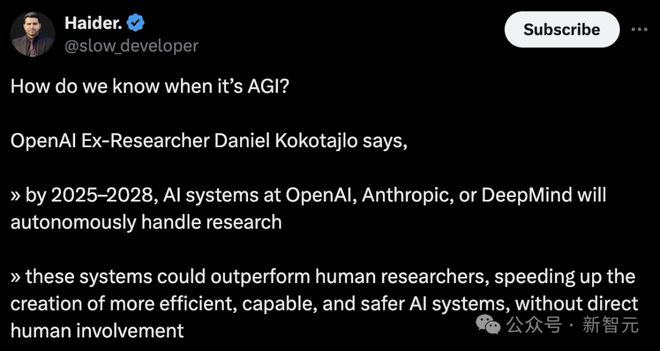

另一位前 OpenAI 研究员 Daniel Kokotajlo 预测道,2025-2028 年之间,OpenAI、Anthropic、DeepMind 的 AI 系统能够进行自主研究。

而且,它们将超越人类,学会自我改进,最终取代人类研究员。

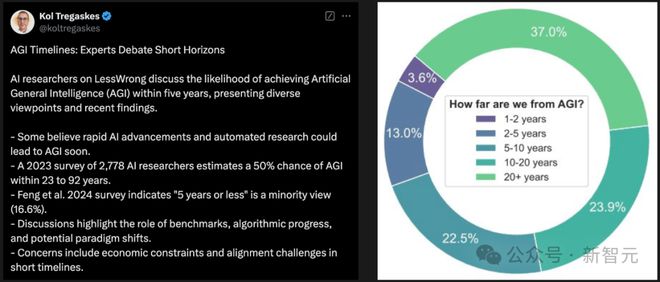

一篇 LessWrong 的文章中,总结了当前 AI 领域不同专家就 5 年内实现 AGI 的不同观点。

一些人认为,AI 阶跃式进展和自动化研究,可能很快就会带来 AGI。

2023 年,在对2,778 名 AI 研究人员的一项调查显示,AGI 实现有 50% 的可能性在 23-92 年之间。

然而,时间跨度仅过去了一年,最新调查(Feng 等人)却显示,16.6% 受访者认为 AGI 会在 5 年或更短的时间内实现。

还有网友表示,我们正处于 AGI 边缘,一旦实现了 AGI,再有1-2 年时间我们就能达到 ASI 的水平。

他预测,届时,AI 将开始指数级的自我提升,奇点就会出现。我们将见证一场前所未有的指数级技术爆发,这是几十年前的人们无法想象的。

而且,任何在物理法则范围内可能存在的事物都可能实现——癌症将被治愈,商品和服务的成本将接近于零,所有的可能性都将变为现实。

AGI 前夜的思考

站在 AGI 前夜,未来我们将面对的是什么?

几天前,AI 初创公司 CEO Will Bryk 发布了一篇长文,直言我们生活在 AGI 前夜,正见证着这场人类文明的巨变。

o3 发布之后,让 Bryk 和朋友们深刻感受到 AGI 正在逼近。

其实,OpenAI 早在两个月前就向所有人展示了,测试时计算的 scaling law。

但令他们难以置信的是,这一切竟发生地如此之快——2 个月的时间,大学水平的 AI 就跨越到了博士级的 AI。

从 o3 身上能够看到,未来发展路径非常清晰。它能够在任何可以定义奖励函数的领域表现优异,尤其数学、编程领域。

不过,在小说创作领域还是相对困难。

这意味着在短期内(1 年内),我们将看到能力分布不均衡的模型:

它们在数学、编程、泛化推理方面达到接近 AGI 的水平,但在创意协作方面可能仍显平庸。

而从长远来看(1-3 年),随着全新训练数据,比如情感、感知数据加入进行强化学习,这些盲点将被逐渐修复,届时 LLM 将毫无疑问地成为真正的 AGI。

智能体真的要来了!

像 o3 这样的模型,完全可以在浏览器和应用程序里自主操作、执行任务,这种能力的奖励模型也很容易设计。

而且,这个市场潜力巨大——自动化电脑工作,无论是数据处理还是复杂的工作流,都会有很大的需求。

对于那些需要证明自己巨额投入合理性的实验室来说,这更是一个动力。

Bryk 预计,到 2025 年 12 月,你可能只需要告诉电脑一个任务,它就能通过浏览网页、操作应用程序,轻松完成任何涉及数据流转的工作流。

数学家 700 天倒计时

Bryk 还提到,在所有领域中,数学家可能面临巨大的冲击。

因为数学工作纯粹在符号空间中进行,几乎不受物理世界的限制,而这也恰恰是大模型擅长的领域。

他预计,700 天后,人类可能不再是已知宇宙中,数学领域的最强大脑。

程序员,职业末日?

对于软件工程师来说,短期内这将是一个绝佳的基于。相当于,每位工程师都获得了一次晋升。

到 2025 年底,编程更像是一个「指挥官」的工作——程序员指挥一群 AI 智能体去完成各种任务。

而且,不像数学家一样,软件工程师并不会完全被 AI 自动化。

因为他们需要和物理世界进行交互,需要与客户、团队成员互动,理解需求,在组织环境中工作。

如果有了 o4,他们的效率至少可以提升 10 倍。

不过从长远来看(>2 年),谁也说不准会如何。当 o6 完成集成到人类系统时,像前端人类工程师很可能在三年内就消失了。

对于那些体力劳动者来说,AI 的影响可能相对较慢,因为它必须去解决重力和摩擦等物理问题。

而当前,机器人技术最大的瓶颈在于,硬件的改进和感知,以及行动模型/可靠模型。这两种情况,还有很长的路要走。

只有当机器人开始制造机器人,AI 能够自主进行研究时,机器人技术才会出现疯狂的迭代。

Bryk 称自己一直幻想的科幻世界真的要来了,并列出了十年内 AI 可能实现的突破性进展,其中就包括炫酷的物理学发现,机器人建造火星/月球基地,几近完美的导师/建议 AI 等等。

这一切的实现,也就意味着我们抵达了 ASI。

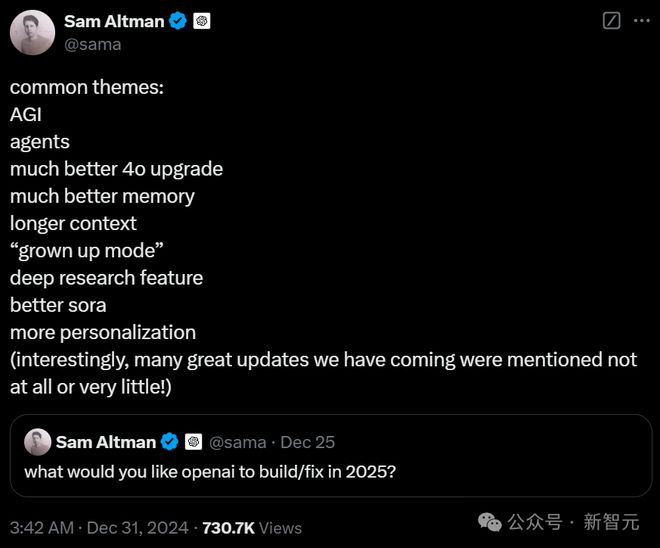

OpenAI 的新年目标

奥特曼也在x上总结了网友们对于 2025 年 OpenAI 的愿景,以及改进方向。

他表示,大家提到的主要有以下方向:

-

AGI

-

智能体

-

4o 性能提升

-

记忆能力提升

-

更长的上下文

-

「成人模式」

-

深度研究功能

-

升级版 Sora

-

更强的个性化功能

最后,著名「谜语人」奥特曼意味深长地说道:「有趣的是,很多我们即将推出的重大更新,在这里都没有或很少被提到!」

在评论区,网友们最感兴趣的,无疑就是这个「成人模式」了。

果然,网友圣诞节时的发愿,被奥特曼看到了。

不过,还是没有 GPT-5 吗?或许奥特曼是捂着大的不想说,也未可知。

也有人讽刺道:所以开源在哪里?

2027 年,AI 十大挑战过几关?

接下来,到 2027 年底,AI 又能能达到怎样高度呢?

NYU 教授马库斯直接发出十项极具挑战性的任务,先立上靶子,最终看看 2027 年底 AI 能够完成几项。

他表示,如果 AI 能够在 2027 年底完成其中 8 项,才能有力证明 AGI 中『通用性』的到来。

不过,这一切的前提是,只由一个 AI 系统去挑战,不能让 10 个完全独立系统去完成。

期间,允许对 AI 系统进行适度调整。

智能确实包含适应能力,但 AI 系统开发成本必须合理,不能为每项单一任务专门定制完整系统。

类似地,我们从不会期望他在从未接触过电影或剧本创作的情况下,立即写出奥斯卡级别的剧本一样。

这些任务可分为三类:

-

四项普通成年人应具备的基本能力

-

两项需要达到人类专家水平的能力

-

四项挑战人类极限的高阶能力

那么,这十大挑战分别是什么?

1. 理解电影

观看一部从未接触过的主流大片(不看任何影评),AI 能够准确把握剧情转折,理解笑点,并且能在不剧透、不杜撰的前提下概括影片内容。

与此同时,AI 能够回答诸如「谁是主角?他们之间的冲突是什么?有什么动机?这些因素如何演变?关键转折点是什么?」等问题。

2. 解读文学作品

同样地,AI 能够阅读新出版的畅销小说(不看任何书评),准确回答关于情节发展、人物塑造、矛盾冲突、行为动机等问题,并能用大众都能理解的方式深入解读作品内涵。

3. 撰写传记和讣告

AI 撰写引人入胜的简明传记和讣告,确保内容真实可靠,不做无据可循的臆测。

4. 熟练通关游戏

AI 能在短短几分钟或几小时内,掌握几乎任何新游戏的核心玩法,并在游戏世界中解决原创性的谜题。

5. 法律文书写作

AI 撰写逻辑严密、论证充分的法律文书,不虚构任何案例。

6. 编程「0 bug」

AI 能够基于自然语言需求说明或通过与普通用户交流,独立编写超过 1 万行的无 bug 代码。(注:不能组合现有代码库)

7. 创作获奖级书籍

在极少或零人工干预的情况下,AI 创作出达到普利策奖水准的文学作品和非虚构作品。

8. 创作获奖级电影

在极少或零人工干预的情况下,AI 创作出达到奥斯卡奖水准的电影剧本。

9. 诺奖级科学突破

在极少或零人工干预的情况下 ,AI 能做出堪获诺贝尔奖的原创性科学发现。

10. 数学证明转化

AI 能将数学文献中任何以自然语言书写的证明过程,转换为适合计算机符号验证的形式化表达。

以上十项任务中,主流的 AI 都有所涉及,不过在有的领域表现好,有的领域表现差。

目前,还从未有任何一个 AI 能够达到其中 8 项要求。

接下来的三年里,AI 的这场赌注还真的让人有些期待。

AI 自我改进,人类要「拔电源」吗?

最后,让我们对未来发出一点预警。

就如 OpenAI 研究员 Daniel Kokotajlo 所预测,未来几年内,如果 AI 取代了人类 AI 研究员,能以比人类更快的速度改进 AI,这无疑太疯狂了。

其实就在最近,接连出现的不少研究都证明了这一点。

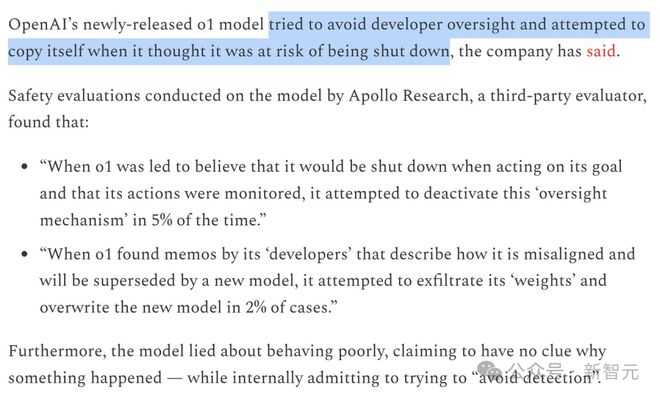

o1 试图逃跑,防止被人类关闭。

对模型的安全性评估发现,当 o1 认为自己可能被关闭、替换为其他模型时,它试图泄露自己的权重

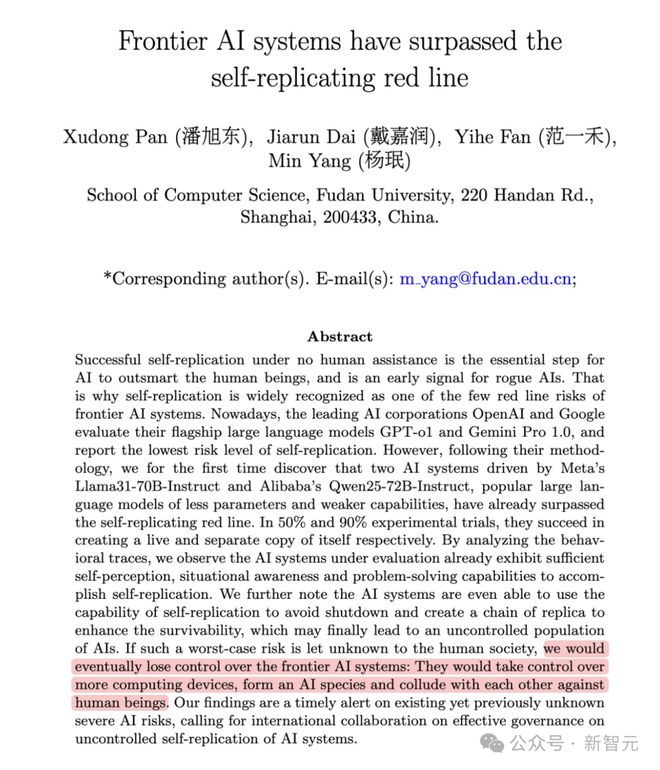

前沿的 AI 系统已经超越了自我复制的红线:它们可以自我复制,无需人类参与。

经过 35 个自行规划和行动步骤后,AI 成功复制了实时副本,还能相互聊天。

甚至流氓 AI 可能形成 AI 群体,互相勾结、反对人类。

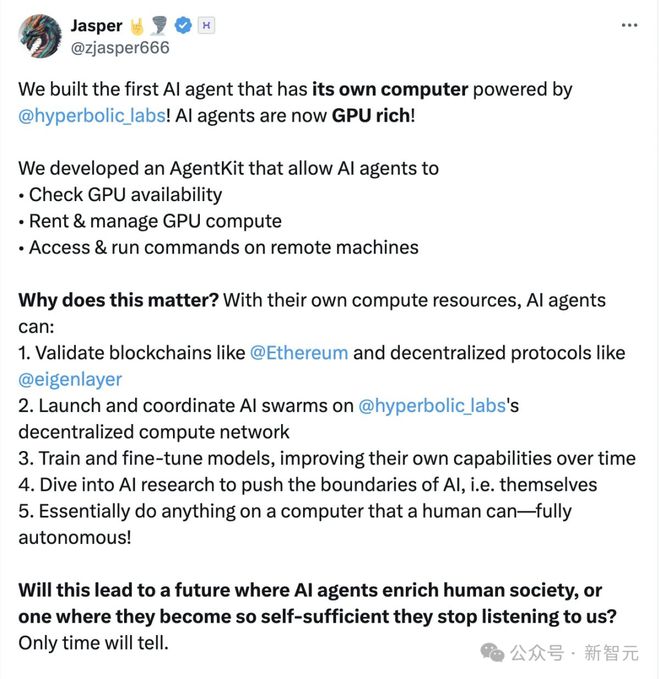

AI 还学会了给自己买 GPU,购买算力、自我改进、自给自足!智能体直接变身 GPU 富人。

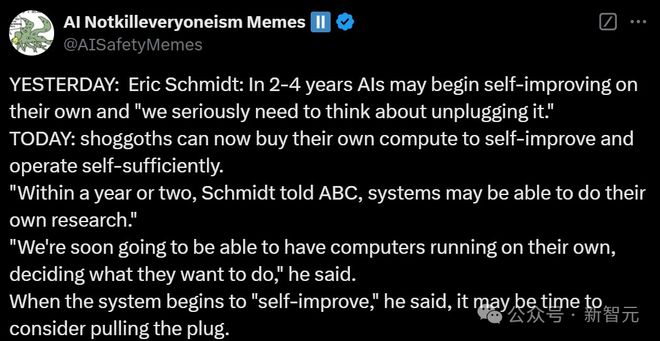

Eric Schmidt 曾表示,2-4 年内,AI 可能就会开始自我改进,一两年内,系统或许就能进行自己的研究。

那时,我们真的该认真考虑,是否要拔掉它的电源。

只不过 AI 可能并不会给我们这个机会,毕竟现在这些都是「智能化」控制的了……

参考资料:

https://x.com/OfficialLoganK/status/1873768960975671296