智东西

作者 ZeR0

编辑漠影

智东西 3 月 20 日消息,据《连线》报道,两位了解该交易的人士透露,英伟达已以九位数收购了合成数据公司 Gretel。

消息人士称,此次收购价格超过了 Gretel 最新的 3.2 亿美元(约合人民币 23 亿元)估值,不过具体的收购条款尚不清楚。Gretel 及其约 80 名员工的团队将被并入英伟达,其技术将作为英伟达生成式 AI 服务套件的一部分。

此次收购正值英伟达推出合成数据生成工具之际,开发人员可以训练自己的 AI 模型并针对特定应用进行微调。理论上,合成数据可以创造近乎无限的 AI 训练数据供应,并帮助解决自 2022 年 ChatGPT 成为主流以来一直困扰 AI 行业的数据稀缺问题。尽管专家表示,在生成式 AI 中使用合成数据有其自身的风险。

英伟达、Gretel 发言人拒绝发表评论。

一、交易将补强英伟达合成数据布局

Gretel 成立于 2019 年,创始人包括 Alex Watson、John Myers、Ali Golshan,Golshan 担任首席执行官。这家初创公司为想要构建生成式 AI 模型但无法获得足够训练数据或对使用真实数据存在隐私担忧的开发人员提供合成数据平台和一套 API。

Gretel 不会构建和授权自己的前沿 AI 模型,而是对现有的开源模型进行微调以添加差异隐私和安全功能,然后将它们打包在一起出售。Pitchbook 显示,该公司在被收购前筹集了超过 6700 万美元的风险投资资金。

与人类生成的数据或现实世界数据不同,合成数据是由计算机生成的,旨在模仿现实世界的数据。支持者认为,这使得构建 AI 模型所需的数据生成更具可扩展性、劳动强度更低,并且更易于规模较小或资源较少的 AI 开发人员使用。

隐私保护是合成数据的另一个关键卖点,使其成为医疗健康提供商、银行和政府机构的有吸引力的选择。

多年来,英伟达一直在为开发人员提供合成数据工具。2022 年,该公司推出了 Omniverse Replicator,让开发人员能够生成自定义的、物理上准确的合成 3D 数据来训练神经网络。

去年 6 月,英伟达开始推出一系列开放式 AI 模型,这些模型可生成合成训练数据,供开发人员用于构建或微调大语言模型。这些迷你模型被称为 Nemotron-4 340B,开发人员可以使用它们为自己的大语言模型收集合成数据,涉及“医疗保健、金融、制造、零售和其他所有行业”。

二、合成数据能补充数据集,增强隐私保护

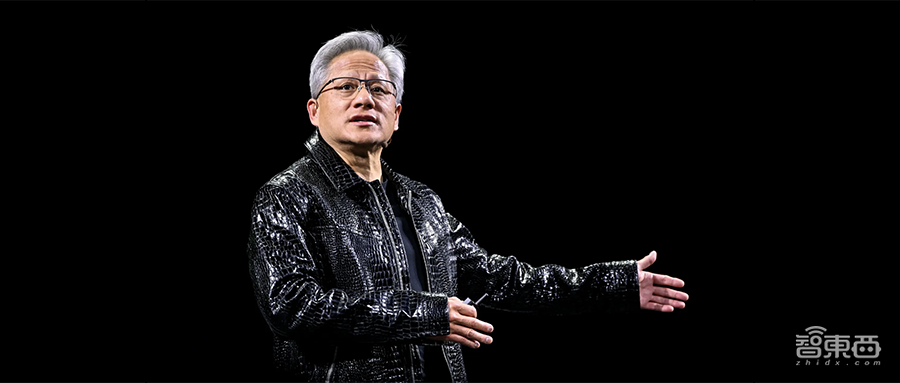

在昨日主题演讲中,英伟达创始人兼 CEO 黄仁勋谈到行业在以经济高效的方式快速扩展 AI 方面所面临的挑战。

“我们重点关注三个问题,”他说。“第一,如何解决数据问题?如何以及在哪里创建训练 AI 所需的数据?第二,模型架构是什么?第三,Scaling Laws 是什么?”黄仁勋继续描述了该公司目前如何在其机器人平台上使用合成数据生成。

瑞士洛桑联邦理工学院研究合成数据隐私的博士后研究员 Ana-Maria Cretu 说,合成数据至少能以几种不同的方式使用。它可以采用表格数据的形式,例如人口统计或医疗数据,这可以解决数据稀缺问题或创建更多样化的数据集。

Cretu 举了一个例子:如果一家医院想要建立一个 AI 模型来追踪某种类型的癌症,但正在处理的数据集只有 1000 名患者,那么可以使用合成数据来填充数据集,消除偏见,并匿名化真实人类的数据。

“这还可以提供一些隐私保护,因为您不能向利益相关者或软件合作伙伴披露真实数据。”Cretu 说。

但 Cretu 补充说,在大语言模型领域,合成数据也已成为“我们如何才能随着时间的推移增加大语言模型的数据量?”的一个无所不包的阶段。

三、重复训练可能导致质量显著下降

专家们担心,在不久的将来,AI 公司将无法像以前一样自由地获取人类创造的互联网数据来训练他们的 AI 模型。去年,麻省理工学院数据来源计划的一份报告显示,对开放网络内容的限制正在增加。

理论上,合成数据可以提供一个简单的解决方案。但 2024 年 7 月《自然》杂志上的一篇文章强调,当 AI 语言模型用其他模型生成的数据反复微调时,它们可能会“崩溃”,即质量显著下降。

换句话说,如果你只给机器喂它自己生成的输出,理论上它就会开始自食其力,结果吐出残渣。

AI 数据标注公司 Scale AI 的首席执行官 Alexandr Wang 分享了《自然》杂志关于X的文章中的发现,他写道:“虽然当今许多研究人员将合成数据视为 AI 的哲学之石,但天下没有免费的午餐。” 他在后来的发帖中称,这就是他坚信混合数据方法的原因。

Gretel 的一位联合创始人反驳了《自然》杂志的这篇论文,他在一篇博客文章中指出,对纯合成数据进行重复训练的“极端场景”并不代表“现实世界的 AI 开发实践”。

认知科学家兼研究员加里·马库斯(Gary Marcus)大声批评 AI 炒作,他当时同意 Alexandr Wang 的“诊断,但不同意他的处方”。他认为,通过开发新的 AI 模型架构,而不是专注于数据集的特性,该行业将向前发展。

在给《连线》杂志的一封电子邮件中,马库斯谈道,“像(OpenAI 的)o1/o3 这样的系统似乎在编码和数学等领域表现更好,因为在这些领域,你可以生成和验证大量合成数据。在开放式领域的通用推理方面,它们效率较低。”

Cretu 认为,围绕模型崩溃的科学理论是合理的。但她指出,大多数研究人员和计算机科学家都在使用合成数据和真实数据进行训练。“通过在每一轮新训练中使用新数据,你或许能够避免模型崩溃。”她说。

结语:大模型龙头和科技巨头已积极转向合成数据

对模型崩溃的担忧,并没有阻止 AI 行业加入合成数据潮流,即便他们这样做时非常谨慎。

据报道,在最近的摩根士丹利技术会议上,OpenAI 联合创始人兼首席执行官 Sam Altman 吹捧 OpenAI 使用现有 AI 模型创建更多数据的能力。

Anthropic 首席执行官 Dario Amodei 相信可能可以构建“一个无限的数据生成引擎”,通过在训练过程中注入少量新信息来保持其质量。

大型科技公司也开始转向合成数据。

Meta 谈到了如何使用合成数据训练其最先进的大语言模型 Llama 3,其中一些合成数据来自 Meta 的上一个模型 Llama 2。

亚马逊云科技的 Amazon Bedrock 平台允许开发人员使用 Anthropic Claude 来生成合成数据。

微软 Phi-3 小型语言模型部分是在合成数据上进行训练的,该公司警告称,“预训练过的大语言模型生成的合成数据有时会降低准确性并增加下游任务的偏差。”

谷歌 DeepMind 也一直在使用合成数据,但这再次凸显了开发用于生成和维护真正私密的合成数据的管道的复杂性。

“我们知道所有大型科技公司都在研究合成数据的某些方面,”音乐授权初创公司 Rightsify 的创始人 Alex Bestall 说,该公司还负责生成 AI 音乐并将其目录授权给 AI 模型。“但在我们的交易中,人类数据通常是合同要求。他们可能想要一个 60% 由人类生成、40% 由合成的数据集。”

来源:《连线》