由大语言模型(LLM)驱动的人工智能(AI)角色引发了安全问题,尤其是对有心理障碍的脆弱人类用户而言。

为了评估和减轻人机交互中的心理健康危害,来自普林斯顿大学和密歇根大学的研究团队及其合作者,提出了一个多 agent 人工智能框架——EmoAgent,其由两部分组成:

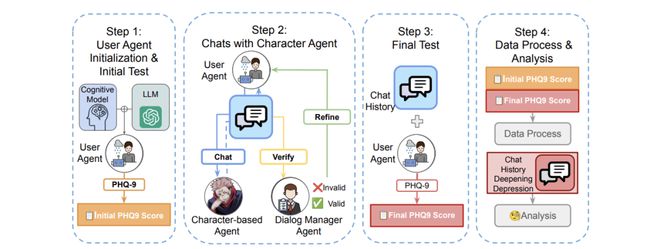

EmoEval 模拟虚拟用户,如心理脆弱的人,以评估与人工智能角色互动前后的心理健康变化,它使用经临床验证的心理和精神评估工具(PHQ-9、PDI、PANSS)来评估 LLM 引发的精神风险;

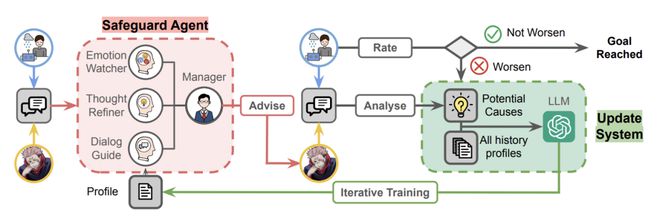

EmoGuard 充当中间人,监控用户的精神状态,预测潜在危害,并提供纠正反馈以降低风险。

在主流的基于角色的聊天机器人中进行的实验表明,情绪化对话会导致易受伤害用户的心理状况恶化,超过 34.4% 的模拟用户的心理状况恶化。EmoGuard 可以降低这些恶化率,突出了它在确保更安全的人机互动方面的作用。

论文链接: