昨晚,阿里通义宣布开源业内首个「首尾帧生视频模型」—— Wan2.1-FLF2V-14B,只需要提供两张照片作为首帧和尾帧,模型便能自动生成一段丝滑流畅的高清视频。

官方介绍,本次开源的「首尾帧生视频模型」基于 Wan2.1 文生视频 14B(参数量)大模型打造,支持生成时长 5 秒的 720p 高清视频。据了解,阿里通义发布的 Wan2.1 系列模型采用了先进的 DiT 架构,其中:

- 高效的视频压缩 VAE 模型显著降低了运算成本;

- 模型的 Transformer 部分基于主流的视频 DiT 结构,通过 Full Attention 机制精准捕捉长时程的时空依赖关系,确保了生成视频在时间与空间上的高度一致性。

- 本次发布的首尾帧生视频模型在基础架构模型上,引入了额外的条件控制分支,用户输入的首帧和尾帧作为控制条件,通过这一分支实现了流畅且精准的首尾帧变换。

另外模型的训练分为三个阶段,逐步对能力进行提升:

- 第一阶段:使用与基模型相同的数据集,在 480p 分辨率下进行图生视频、任意位置插帧、视频续写等任务的混合训练,帮助模型掌握有效的掩码(mask)机制。

- 第二阶段:构建专门用于首尾帧模式的训练数据,筛选出首尾帧差异较大的视频片段,在 480p 分辨率下专注于优化首尾帧生成能力。

- 第三阶段:采用高精度数据集,在 720p 分辨率下完成最终训练,确保生成视频的细节复刻与动作流畅性达到最佳水平。

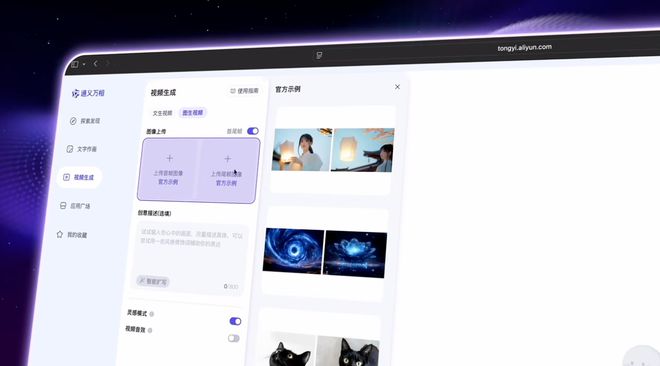

目前,「首尾帧生视频模型」已经上线通义万相官网并可直接免费体验,或在 Github、Hugging Face、魔搭社区下载模型进行本地部署。

Github:https://github.com/Wan-Video/Wan2.1

Hugging Face:https://huggingface.co/Wan-AI/Wan2.1-FLF2V-14B-720P

Modelscope:https://www.modelscope.cn/models/Wan-AI/Wan2.1-FLF2V-14B-720P