推理时计算的扩展大大提高了语言模型的推理能力。然而,现有方法有很大的局限性:序列化的思维链方法会产生过长的输出,导致延迟增加和上下文窗口耗尽,而并行方法(如自一致性)则存在协调不足的问题,导致冗余计算和有限的性能提升。

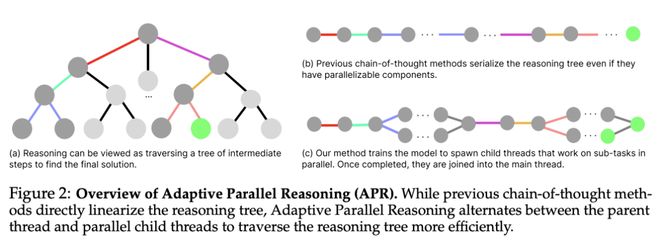

为了解决这些不足,加州大学伯克利团队推出了一个新的推理框架——自适应并行推理(Adaptive Parallel Reasoning,APR),其可以使语言模型端到端协调串行和并行计算。APR 通过使用 spawn () 和 join () 操作实现自适应多线程推理,从而推广了现有的推理方法。一个关键的创新是端到端强化学习策略,通过优化父线程和子线程来提高任务成功率,而无需预定义的推理结构。

倒计时(Countdown)推理任务实验证明了 APR 的显著优势:(1)在相同上下文窗口内具有更高的性能(4k 上下文时为 83.4% vs. 60.0%);(2)随着计算量的增加,具有更出色的可扩展性(20k token 时为 80.1% vs. 66.6%);(3)在同等延迟条件下提高了准确性(约 5000ms 时为 75.2% vs. 57.3%)。

他们认为,APR 标志着语言模型朝着通过自适应计算分配自主优化推理过程的方向迈出了一步。

论文链接:https://arxiv.org/abs/2504.15466