GameLook 报道/智能 NPC 是国内玩家非常熟悉的 AI 应用领域之一,但真正能做的厂商却并不多。GDC2025 大会上,腾讯 RTC 产品架构师 Chen Jiayi 分享了实时对话式 AI(Conversational AI)赋能游戏 NPC 的实际案例。

该技术可以支持低延迟的 AI 语音互动,确保游戏过程流畅顺滑,并具备精准的语义理解能力,从而实现准确回应。在全球范围内,腾讯首次将大语言模型(LLM)与实时音视频(RTC)相结合,并应用于 FPS 游戏中的队友及自动交互场景,代表了行业前沿的 AI 技术探索。

以下是 Gamelook 听译的完整演讲内容:

Chen Jiayi:

我是 Joy,负责腾讯 RTC 产品的解决方案架构,很高兴分享我们的对话式 AI 游戏解决方案。

先说今天的分享安排,我今天会谈到 3 个话题:首先是当今游戏业的对话式 AI 应用;其次,我会对 GME 做一个简短介绍,它是一个专门为游戏设计的游戏内语音聊天产品;最后,我会简单介绍一下我们的对话式 AI 解决方案在游戏之外的场景应用,比如客户服务 AI。

需要提醒的是,有两件事我会提到很多,第一个是 GME,指的是游戏多媒体引擎,这是我们专门为游戏做的解决方案。游戏场景之外,我会谈到 TRTC,指的是腾讯 RTC,即腾讯实时通讯。

对话式 AI 在游戏中的应用

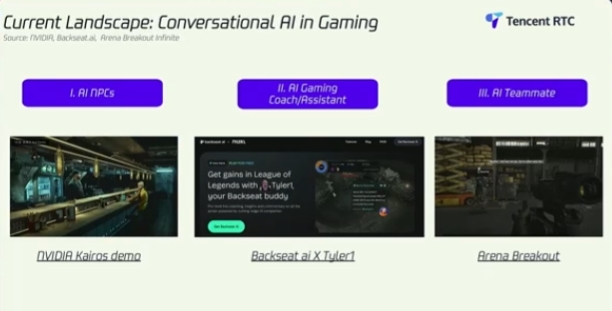

近些年,我们都看到大语言模型(LLM)变得越来越能够参与到游戏流程之中,这改变了 AI 与玩家的互动方式。为了更好地理解这个领域,我们来看三个游戏关键场景中的不同应用:

第一个类别是 AI 支持的 NPC,这是一个 AI 支持的、用于动态对话的 NPC。英伟达的“Kairos Demo”就是该应用很好的案例。第二个应用就是 AI 如何担任游戏教练/助手,以提供实时训练帮助玩家提升他们的游戏技巧。比如 Backseat AI 就是一个 AI 助手,它可以分析玩法并且像教练一样分享洞察。

第三个类别展示的是《暗区突围》Demo,它是一个 AI 驱动的队友。在多人或合作游戏中,AI 队友可以扮演很出色的玩家或者提供辅助。作为案例展示,我将在未来玩这个游戏 Demo,而 AI 队友可以在战斗场景中帮助玩家。

1、AI NPC

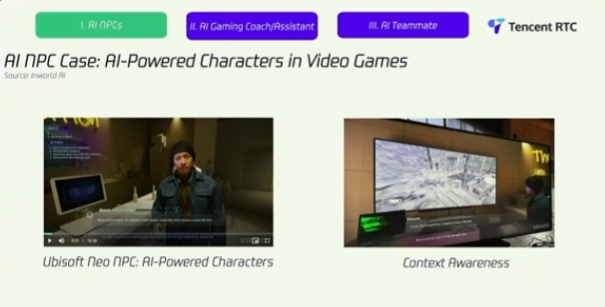

在去年的 GDC 2024 大会上,育碧介绍了 Neo NPC,这是一个使用内部引擎研发的 AI 系统,为了让 NPC 更具互动性并意识到玩家行为。这些 NPC 可以进行完整的对话并记住过去的互动,而非遵循脚本。

我记得当时展示的 Demo 中,当玩家与 NPC 聊天的时候,NPC 能够发现玩家正在吃汉堡,在后来的对话中,NPC 甚至还提到了这件事。这让玩家与 NPC 之间的互动更具吸引力,更加个性化,也更有意义。

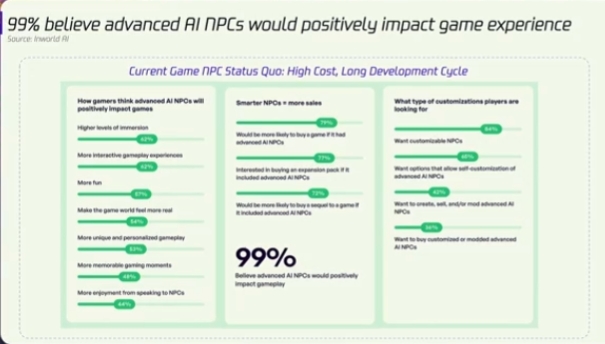

据 Inworld AI 做的一份调查显示,99% 的玩家认为更聪明的 NPC 可以提升玩法体验,带来更长的游戏时间和更多的消费。这真正展示了 AI 可以深化玩家参与度,同时推动商业化的增长。

但是,传统 NPC 的研发缓慢,且代价高昂。例如,《荒野大镖客2》用了 8 年的时间做了 1000 多个 NPC,每一个都需要定制化配音和动画,这极大限制了游戏工作室对其游戏产品规模化的能力。

然而,AI 支持的 NPC 可以通过允许无脚本的自然对话解决这个问题。在更好的玩法之外,AI NPC 还可以带来商业机会,玩家也愿意为更智能的 NPC 支付更多,使得 AI 成为了更高收入、更好的留存率和新变现模式的关键驱动力。

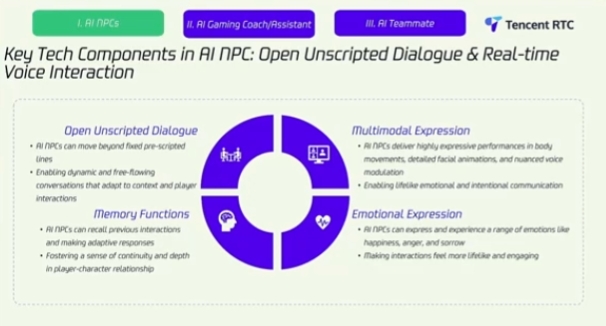

这张图片中,我强调了支持 AI NPC 的四个技术组件:首先是开放无脚本对话,这可以帮玩家和 AI NPC 进行自然对话;其次是记忆功能,这意味着 NPC 可以回忆起玩家选择、偏好和过去的对话等细节。

第三是多模型表达。AI NPC 远不只是文字对话,他们还会使用身体动作和面部动画,以带来更逼真的情感表达。最后一个是情感表达。AI NPC 可以展示大量的情绪,包括喜怒哀乐等等。

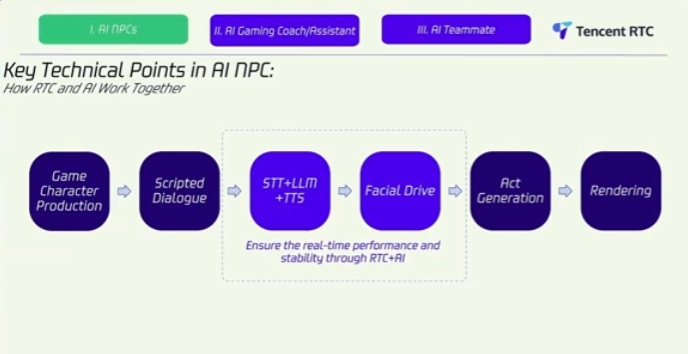

这张图片中,我强调的是 AI NPC 当中的 RTC 如何与 AI 一起工作的关键技术点。它的基础,是先从游戏角色制作开始的,接着是脚本对话,最初的对话是为了定义故事线和必要的故事情节,作为游戏剧情的框架。

随后来到第三个部分,它包括 STT、LLM 和 TTS,STT 代表的是语言转文字,它可以把玩家说的话转化为文字,然后交给 LLM 生成反应,TTS(文字转语音)会将生成的文字转化为语音,以传递 AI 实时生成的语音。随后,使用面部驱动同步唇部动作和带面部表情的语音,带来真实的的角色反应。

然后,转向美术生成,最后是渲染环节。最后一个阶段打磨 NPC 的视觉效果,并将他们无缝集成到游戏环境中。

2、AI 游戏教练/助手

接下来说的是第二种应用,AI 教练或者 AI 助手,当然,有时候我们也把它称之为 AI 伴侣。

这里我将展示 Backseat AI 与知名主播 Tyler1 互动的一个 Demo:

这是展示 Backseat AI 通过 AI 驱动的游戏教练带来强大游戏体验的案例,它可以在你玩游戏的时候提供实时洞察,策略和提示。它集成到了《英雄联盟》等游戏中,分析玩家决策并提供站位、目标和战术方面的指引。

与静态的新手教学不同,Backseat AI 可以为每一个玩家带来动态化和个性化的训练,Demo 当中实际上还有一个主播,想象一下,如果他们可以说韩语或者中文,那么这个工具就可以专门为你提供训练指引,让游戏学习变得吸引人和具有沉浸感。

另一个案例,微软的 Copilot 作为一个多功能 AI 伴侣,为玩家带来游戏内策略和之外的帮助,集成到了 PC 当中,并兼容《我的世界》这样的游戏。你不仅可以回应玩家请求,还可以建议制作配方、调整系统设定,甚至是优化性能。

展望未来,我们可以看到 AI 正在通过提供实时支持来改变玩家学习和适应游戏的方式。它可以运用在个人训练中,帮助玩家学习游戏机制,在新玩家指引中得到游戏内提示与反馈。另外,你还可以用在英雄学习中,帮助玩家掌握特定英雄,团队合作可以提供实时战术建议。

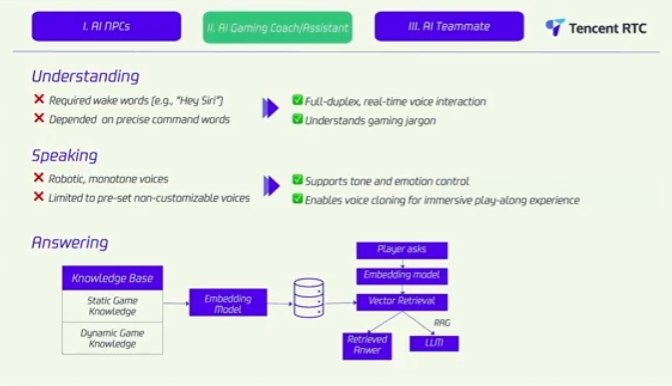

这张图片中,我列出了我们在 AI 训练场景取得了进步的三个核心区域。

我们先说理解,过去,理解需要切入语,比如“hey Siri”,而且它需要精准指令语。然而现在的环境可以进行实时语音互动,它还能懂游戏黑话。

语音方面,过去配音是比较呆板的,而且呈现的语音无法进行定制化,只能支持预制的语言,而非玩家所在地区的语言。然而,当前解决方案引入了语调和情绪控制,让 AI 语音听起来更自然且更有吸引力。

另外,有了语音克隆,玩家们可以使用语言互动沉浸在玩法中,比如他们喜欢的主播声音,就像前面案例中的那样。

图片底部展示的是应答流程:当玩家提出问题的时候,系统首先将请求转化为一个矢量呈现,然后用嵌入模型,它会在一个矢量数据库内搜索,其中包括静态游戏知识和动态游戏知识。静态知识包括游戏策略和机制,动态游戏数据包括了实时匹配数据。

如果直接答案可用,它就会被提取并提供给玩家。如果不能,系统就会部署 RAG,这通过允许更多高级 LLM 检索外部数据库的方式增强了反应的精准度。通过用预训练知识和实时洞察这样做,AI 助手可以提供推荐并带来有关联且个性化的指导。

3、AI 队友

我们来到第三个场景,也就是 AI 队友场景。

可以看到其他队友总是在说收到,意思是他们收到了指令。

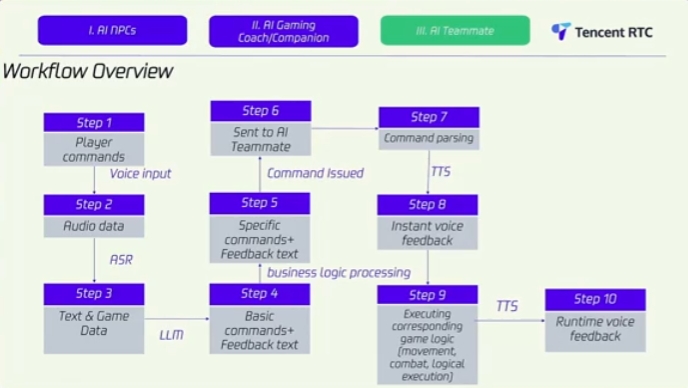

这里,我会谈到 AI 队友处理指令的整体工作流。第一步是玩家指令,这是从玩家发出语音指令开始的,例如让他们的 AI 队友移动、找到一个物体,或者提供指引。捕捉到音频之后,它会通过 ASR(自动语音识别)进行处理,也是语音转文字的。

然后进入第三步,一旦语音转化为文字,它会与实时游戏数据配对,并发送给一个 LLM。后者用游戏上下文环境分析指令,确保它理解玩家的意图。

第四和第五步,系统通过商业逻辑处理请求,将其分类为基础或特定指令,随后准备队的反应。到了第六部,指令会分发给一个 AI 队友,并让他们执行下一个行动。

第七步是指令分解,这是分析指令的过程,然后把它们拆分为能够让系统理解和执行的有结构、可行动的元素。一旦指令被分解,它就可以被转化为游戏特定的 AI 行为。

随后,即时语音反馈会使用 TTS 给到玩家,他们会给出即时反应,如“收到”、“了解”等等。然后到第九步,AI 队友会根据对应游戏逻辑执行,这时候指令就变成了真正的实时游戏内行动。包括移动到特定位置、参与战斗,或者基于游戏环境做出战术决策。最后,再次使用 TTS,玩家可以收到反馈结果

这个系统可以让 AI 队友动态化辅助玩家,带来感觉更自然、更符合上下文环境的语音互动。

腾讯游戏内语音聊天产品 GME

我们看到了对话式 AI 是如何改变游戏的,通过增强 NPC 互动、提升 AI 队友表现,并在游戏活动内带来更真实的实时沟通。但是,如果没有底层技术支持实时语音互动(RTC),以上这些就都不可能实现。

这就要提到 GME,我们的游戏内 RTC 引擎,扮演了至关重要的一部分。在游戏场景中,无缝沟通是团队协同、策略和沉浸感的关键,GME 就是这个一站式游戏语音解决方案,以两种不同方式支持实时语音聊天和语音信息。

第一种是语音聊天,它支持 3D 空间音频效果,让玩家通过直接的语音来侦测队友和敌人,在 FPS、TPS 和社交推演游戏中增强了真实感,它还根据距离在游戏内调整声音。

语音聊天中,它还支持语音变声,最高 100 多种不同特效,你可以安排多房间支持组队或小队沟通。它还可以实现大型多人语音支持,最高支持 1 万名玩家实时沟通,这意味着它特别适合大型战斗和元宇宙活动。

右边是另一种形式,被称为语音信息,最长支持 60 秒语音,并且可以支持语音变声。

GME 还有额外的能力,如 125 个不同语言的实时翻译,还包括语音转文字、文字转语音、音频录制和 DIY 语音变声效果等功能。此外,它可以运用于不同的游戏场景,包括 FPS、TPS、MOBA、MMORPG、桌游、VR、AR 游戏和元宇宙。

最右侧,我强调了几个 GME 功能和性能数据,首先是低时延,我们可以把时延降低到 300 毫秒,相当于一眨眼的时间,确保了实时互动。其次,我们还可以预防网络问题,哪怕是丢包率达到 70% 依然保持高品质沟通,我们还有 24/7 客服、全球覆盖以及多平台支持。

展望未来,我会谈谈 GME 如何在游戏中带来实时语音沟通,通过游戏内语音频道,GME 支持多房间切换,所以玩家可以无缝切换道不同语音聊天室。它还可以运用到团队战斗或者游戏指挥等场景,或者在大厅聊天以及一对一私聊。

或者,对于更大的场景,如大型互动直播,GME 可以支持数千名玩家在大型活动中或者虚拟音乐会中交流。

图片下方的表格中,我放出了流程,你可以看到 GME 是如何带来实时语音交流的。从发送者到接收者,我们基于客户需求使用不同的 SDK,不管是 UE、Unity 还是 Cocos。然后使用这些 SDK 捕捉语音数据,随后发送到媒体服务器,进行处理和转化流程,接着语音数据就发送给了接收者。

我们还与 VoiceMod 进行合作,另外,还想要强调的是,我们与 Audiokinetic 进行合作,我们的 GME 可以无缝与 Wwise 集成。

接下来,分享一个案例,展示 GME 插件如何与 Wwise 无缝合作带来先进的语音聊天技术。

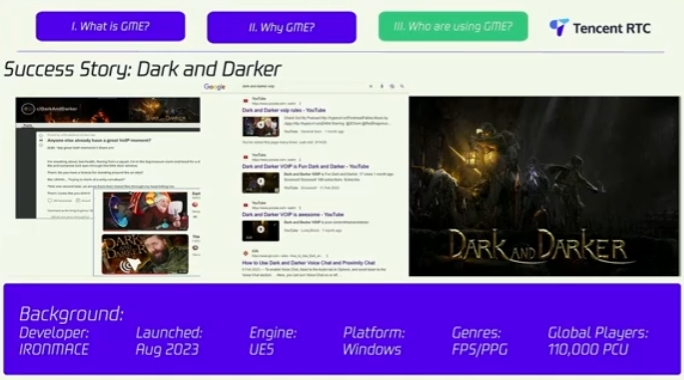

体验了《Darker and Darker》的玩法之后,很多用户讨论说游戏语音技术让游戏变得更好,增加了紧张、真实和深度的合作体验。

在这款游戏里,有两个主要的语音解决方案设计,包括:1)团队语音聊天,让队友之间进行协作,2)近场语音聊天,可以让玩家听到附近其他小队的敌人。

在这个案例中,GME 插件可以无缝与 Wwise 连接,简化了不同场景的语音部署流程。

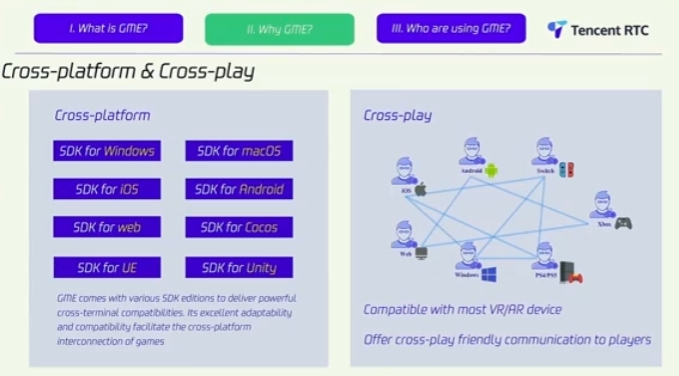

接下来,我想要强调的是为何客户选择了我们的 GME 产品。我们的 GME 为多个平台提供 SDK,包括 Windows、Mac OS、iOS、安卓、Web、Cocos、虚幻引擎和 Unity。它给开发者带来了集成语音交流的灵活性,不管他们的游戏选择了什么平台或者引擎。

与此同时,它对于跨平台也是友好的。GME 移除了平台障碍,让玩家不论在哪里游戏都可以交流,不管是 PC、主机还是移动设备。该系统支持 PS4、PS5、Xbox、Switch、Windows、安卓、iOS 和网页端,使之成为了真正的跨平台解决方案。它还兼容 VR/AR 设备。

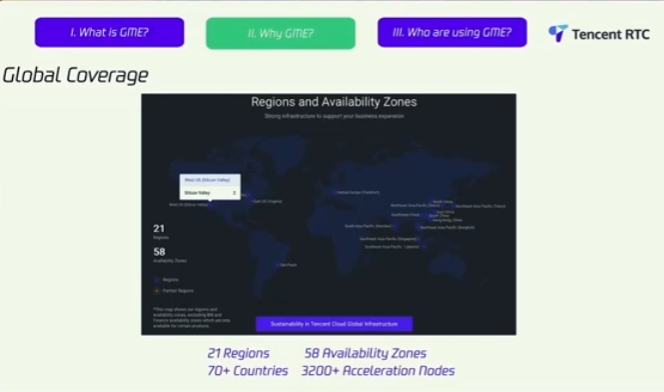

对于实时交流,全球覆盖是至关重要的,我们的产品在 21 个区域运营,在 50 个区域可用,为全球玩家提供高速、低时延连接。通过在 70 个不同国家的 3200 多个加速节点,玩家们可以自动连接到最近的 GME 服务器,将时延降到最低。

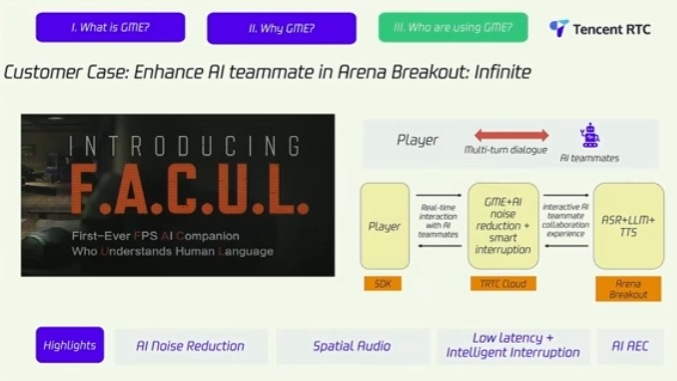

这张图片,展示的是F.A.C.U.L.引擎,全称是 First-Every FPS AI Companion Who Understands Human Language。这是个很有趣的命名,将会在未来部署到《暗区突围:无限》之中。

它在幕后是如何运作的?这就用到了 GME。

右侧这个工作流程图描述了玩家是如何与 AI 队友交流的,首先,玩家说话的时候,SDK 会捕捉降噪和去回音的语音,然后这个语音通过云端传输,确保极低的时延和超高的质量。

接收之后,AI 管线实时处理数据,ASR 将语音转化为文字,让它生成反应,TTS 可以让 AI 说话。然后,这个反应会通过云端返回玩家那里,将对话时延保持到最低。

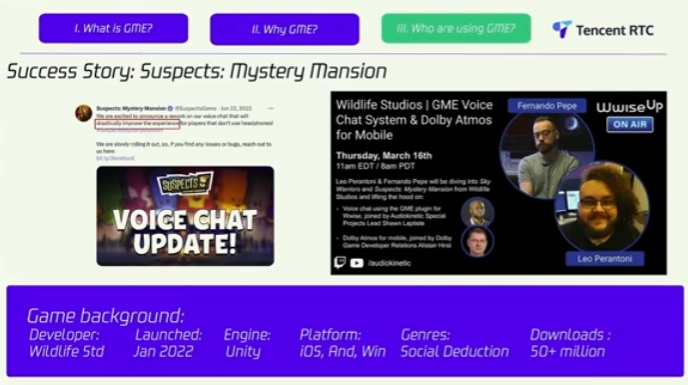

这是一款利用了 GME 的游戏,名字叫做《Suspects:Mystery Mansion》,是一款由 Wildfire Studios 研发的多人推理游戏。在这款游戏里,玩家扮演动物角色,一起来找出谁是谋杀者。这款游戏与同品类游戏最大的不同在于,它带有内置语音聊天功能,我们的 GME 产品在其中扮演了很重要的作用。

对于这款游戏,有非常具有挑战性的需求,我们一起解决了这些问题。首先,玩家的语音会根据游戏内状态发生改变,我们的产品提供灵活的语音频道管理,适应了这种动态化需求。

另外,我们提供高质量、低时延的交流,让游戏里的指责、辩护或者虚张声势都可以被实时听到。此前,Wildfire Studios 也分享过 GME 给游戏带来的帮助,我们对此感到自豪,并且将继续与客户一起成长。

对话式 AI 解决方案

最后这个部分,是我们的对话式 AI 解决方案,非常适合客户支持场景,还能运用到游戏之外的场景。

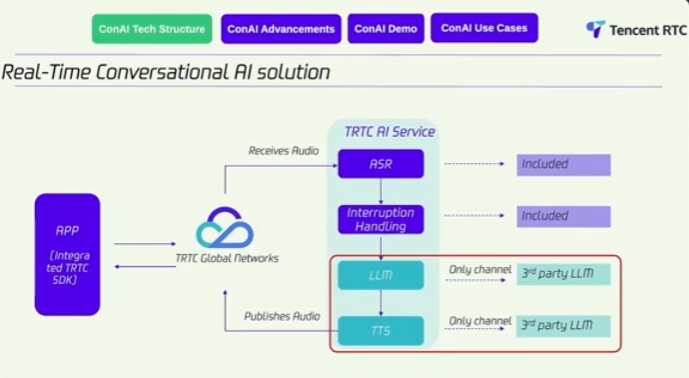

这是我们的实时对话式 AI 解决方案的基础技术结构,左侧是一款应用,不管是软件还是在线应用,都可以与我们的 SDK 集成。它捕捉玩家音频并发送到我们的 TRTC 全球网络,收到语音之后,就会经历 4 个处理流程,我在前面已经讲过好多次。另外,LLM 和 TTS 都可以是来自第三方的,取决于你的需求。这个过程完成后,会发布到我们的 TRTC 全球网络。

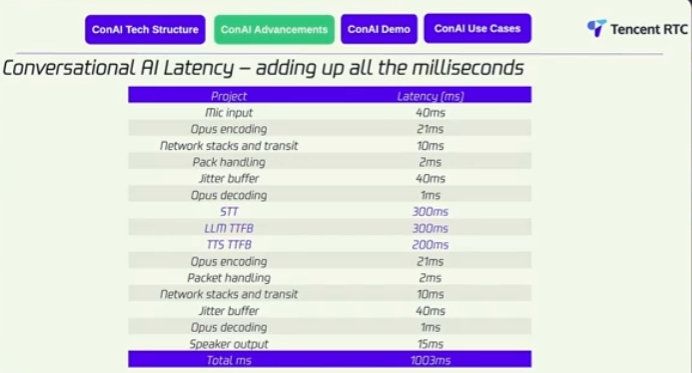

这是使用我们自己的 LLM 和 TTS 的时延性能数据,我们可以看到,STT、LLM 和 TTS 依然是对话式 AI 中时延的主要原因,如 STT 的时延为 300 毫秒,TTS 时延 200 毫秒,这是时延主要的来源。但我们可以做的,就是以流畅的方式做到端对端交流,可以看到,总时延为 1000 毫秒。

以上就是今天分享的全部内容。