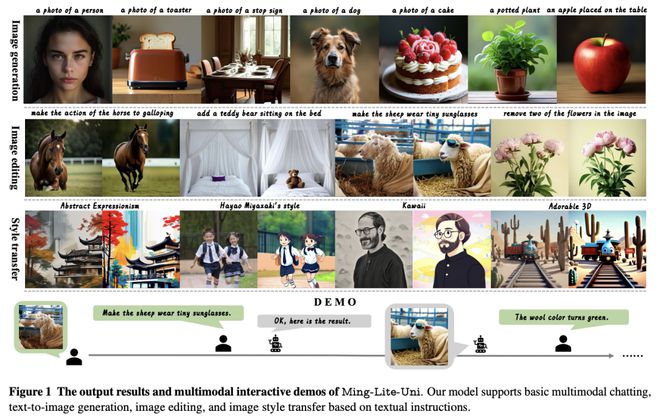

在这项工作中,来自蚂蚁集团的研究团队推出了一个开源多模态框架——Ming-Lite-Uni,其具有新设计的统一视觉生成器和为统一视觉和语言而定制的本地多模态自回归模型。

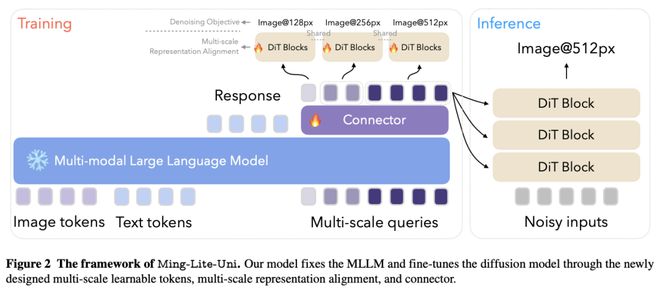

具体来说,该项目提供了集成 MetaQueries 和 M2-omni 框架的开源实现,同时引入了新颖的多尺度可学习 token 和多尺度表征对齐策略。通过利用固定的 MLLM 和可学习的扩散模型,Ming-Lite-Uni 使本地多模态 AR 模型能够执行文本到图像的生成和基于指令的图像编辑任务,从而将其功能扩展到纯粹的视觉理解之外。

实验结果证明了 Ming-Lite-Uni 的性能,并展示了其交互过程中的流畅性。值得注意的是,这项工作与同时进行的多模态人工智能里程碑--如 2025 年 3 月 25 日更新的具有原生图像生成功能的 ChatGPT-4o --相吻合,强调了像 Ming-Lite-Uni 这样的统一模型在通往 AGI 道路上的广泛意义。Ming-Lite-Uni 目前处于 alpha 阶段,不久将进一步完善。

论文链接:

https://arxiv.org/abs/2505.02471

GitHub 地址: