新智元报道

编辑:编辑部

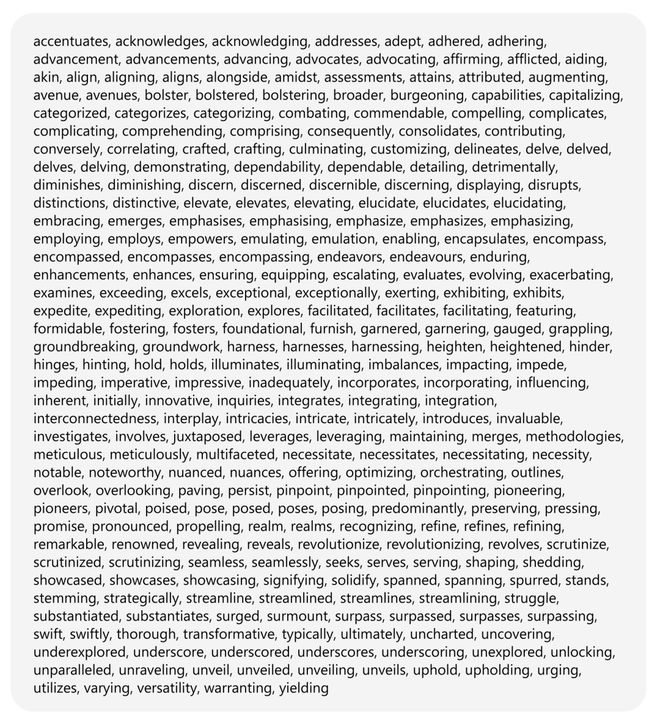

大数据已经能闻出 AI 味儿了!最近,一份席卷生物医学圈的报告发出警告:如果你论文里高频出现 delves、underscores 等 454 个特定词汇,就要小心了——这很可能就是 AI 留下的「指纹」。

如果你在一篇论文里看到下面这 454 个词,就要小心了。

它,很可能是 AI 写的。

正所谓:勇敢的人先享受世界。

一些科学家早早就在投稿给期刊的论文中用上了 AI,并且率先享受到了泼天的发表数量。

甚至有些人用 6 个月,就成为了一个全领域「专家」——投稿给各类专业期刊的 letter 和 comment,方向包括但不限于心脏病学、急诊医学、内分泌学、胃肠病学、肝病学、免疫学、重症监护医学、精神病学、外科学、泌尿学等等……

不过,即便他们十分小心地删除了「我是一个大语言模型」等一眼假的内容,也依然会留下大肆使用 AI 的蛛丝马迹。

来自图宾根大学的 Dmitry Kobak 团队表示,他们找到了一种方法追踪 AI 写作论文摘要的频率。

论文链接:https://www.science.org/doi/10.1126/sciadv.adt3813

他们发现,AI 特别爱用一些词,比如「深入探讨」(delves)「关键的」(crucial)「潜在的」(potential)「显著的」(significant)「重要的」(important),比人类作者用得勤多了。

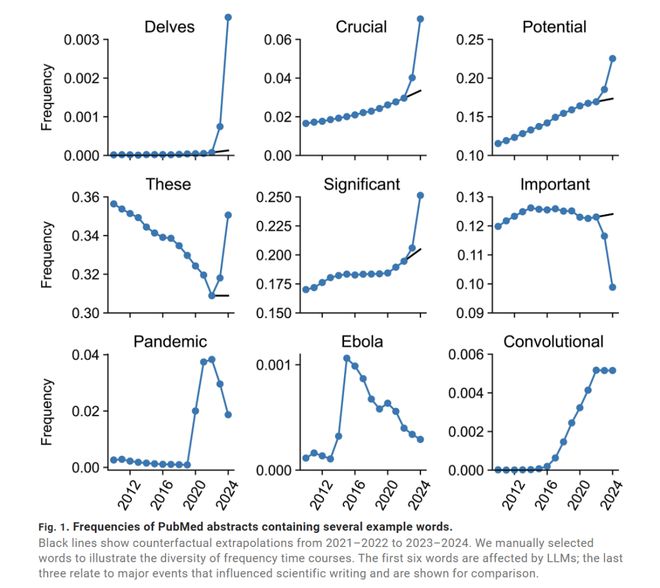

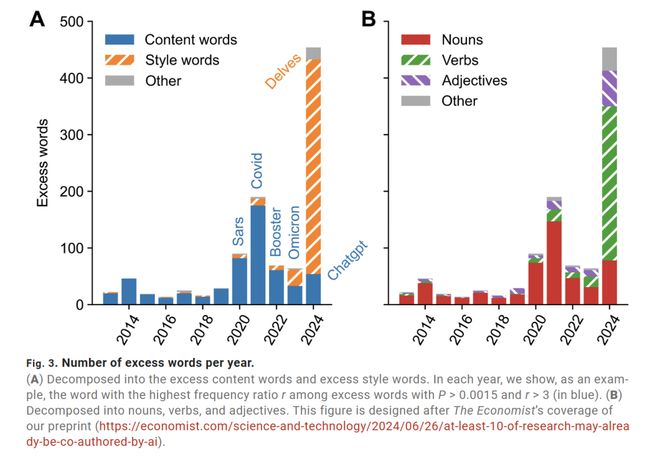

具体来说,研究人员分析了 2010-2024 年间,1510 万篇生物医学摘要的用词,注意到一些词的出现频率蹭蹭上涨。

2024 年,他们发现有 454 个词,AI 用得特别多。

Kobak 团队估算,至少 13.5% 的生物医学摘要有 AI 帮忙的痕迹。在一些国家,不太挑剔的期刊摘要,高达 40% 可能是 AI 搞定的。

看到如此多 AI 撰写的摘要令他感到惊讶。他表示,摘要可是论文结论的精华总结,很多人就只看这一块。

「这么重要的内容,居然让 AI 写?简直难以想象。」Kobak 特别声明,他们自己的论文没用 AI。

13. 5%?还是太保守了!

研究人员分析了 2010-2024 年这 14 年间,发表在 PubMed 上的 1510 万篇英文摘要。

结果发现,2023 年以后,很多词汇出现的频率显著增加。

比如「深入探究」(delves)这个词,2022 年之前每年出现次数稳定在几千次,2024 年却暴增 28 倍;「展示」(showcasing)的使用频率也翻了 10 倍以上。

为了能更好地量化这个增长趋势。研究人员,基于 2021 和 2022 年词频的线性外推计算了 2024 年反事实预期频率。

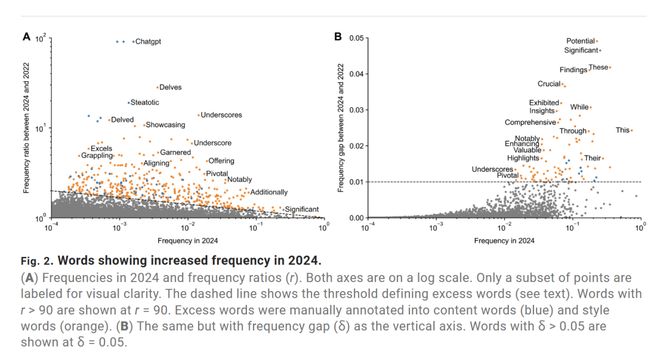

为衡量超额使用情况,有两个关键指标:超额频率差δ=p−q和超额频率比r=p/q。

前者主要突出高频词的超额使用情况,后者则指向低频词的超额使用。

为什么这些词能暴露 AI 痕迹?因为它们大多是不涉及具体科研内容的「风格词」。

研究员利用以上方法,分析了两万六千多个词,发现 2024 年,有些词简直被用烂了。

比如一些显得很专业但有点套路化的表达,像 delves (深入研究)、underscores (强调) 和 showcasing (展示),出镜率高得吓人。

还有一些老熟人,比如 potential (潜力)、findings (发现) 和 crucial (至关重要),也成了重灾区。

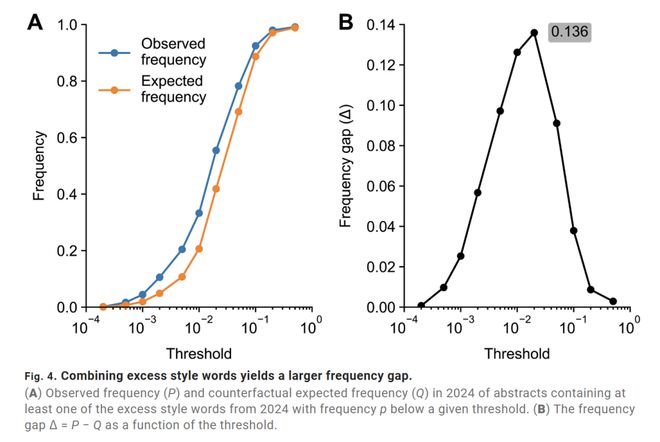

如果 AI 写的论文里,每 10 篇就有 1 篇会用「potential」这个词,而正常写作中 100 篇才出现 1 次,那么「potential」的超额频率是9%,这就意味着至少9% 的论文用过 AI。

但科学家找了 291 个这样的稀有风格词,把它们的影响叠加起来,才得到 13.5% 这个保守值。

AI 参与度高达 41%!

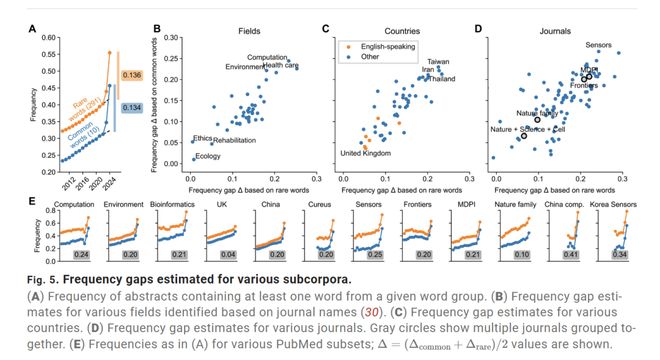

来自非英语国家、发在某些「不知名」期刊(如 MDPI、Sensors)的论文,最有可能带着一股浓浓的 AI 写作腔。

计算生物学研究者最敢用 AI,估计有 20% 的论文摘要经过 AI 处理,而传统临床领域不到5%。

非英语国家的论文中,AI 使用率接近 20%,英语国家只有5% 左右。

最夸张的是发表在 Sensors 上的深度学习论文,AI 使用率估计有 41%。这可能和出版周期和审稿严格程度有关。

顶刊审稿严、周期长,AI 痕迹有更多时间被修改掉,而快审期刊更有可能保留原始 AI 写作风格。

亚利桑那州立大学计算机教授 Subbarao Kambhampati 表示,科学家知道 AI 偏好某些词语,尽管原因还不清楚。

他说,一些科学家故意避免使用像「深入探讨」(delve)这样的词,以免被怀疑用 AI 写作。

但也有些人压根不在乎被抓包。

Kambhampati 举例,放射学期刊的病例报告里居然写着:「抱歉,我是 AI 模型,没法访问实时信息或患者数据。」

AI 写的 letter,该不该发?

Science 最近询问了超过 5000 名研究人员,何时能接受用 AI 撰写论文,结果大家意见不一。

是撰写摘要、整篇论文,还是编辑、总结,对于不同的情况,大家看法也不同。

有人抱怨:「上周我让 ChatGPT 写综述,它居然编造了一个不存在的研究结论。」

这正是科学界最担心的问题。

AI 会一本正经地胡说八道。比如让 AI 总结某领域进展,它可能会把相似研究的结论嫁接过来,甚至虚构数据。

如果训练数据里某类研究占比高,AI 会进一步强化这种偏见。

当大家都用 AI 写作,论文的语言风格会越来越像,甚至连讨论部分的逻辑框架都趋同,这会扼杀创新思维。

斯坦福 AI 医学教育主任 Dr. Jonathan H. Chen 表示:「现在一切都很模糊。我们处于灰色地带,像是西部荒野。」

这引发了一个问题:要是投稿完全是 AI 写的,没有人类作者,期刊该不该直接拒搞?

斯坦福精神病学与行为科学教授 Keith Humphreys 表示,他曾被 Addiction 期刊的一封 letter 欺骗。

Letter 中评论了一篇刚发的论文,写得挺有道理。按照惯例,他把 letter 转给了论文作者,让他们回复。

论文作者却说压根没听说过此人,并表示学术圈子不大,没人认识这号人。

他们搜索了 letter 作者的出版记录,发现了大量出版物,全是各种期刊的读者 letter 和 comment,涵盖心脏病学、急诊、内分泌学、胃肠病学、肝病学、免疫学、重症监护、精神病学、外科和泌尿学等多个领域。

「这些全是在六个月内完成的,他精通每个领域。」Humphreys 说。

这八成是把期刊文章丢给 AI,让它生成给编辑的 letter。他猜想,作者可能是学术岗位,工资跟发表量挂钩。

于是,他回复 letter 作者,如果使用了 AI,必须声明。

作者没有回复。

Humphreys 也没有发表这封 letter。

但问题是,letter 写得不错,也不是传统意义上的欺诈。

但同事认为,既然现在每个人都有聊天机器人,为什么要发表它们写的东西?任何想看此类分析的人都可以自己生成一个。

Humphreys 认为,AI 生成的社论可能还挺有洞见。

但同事的一句话点醒了他:「我关心一篇社论的原因是署名。顶尖学者敢冒职业风险,敢说刺耳或不受欢迎的话。」

Humphreys 深以为然:「AI 没有意义,也没有声誉,我对它没有信任,它不具备道德价值。」

当 AI 开始代笔,我们更需要思考:什么才是科研写作不可替代的核心?

或许不是华丽的辞藻,而是对科学问题的深刻洞察,以及那份探索未知的真诚。

参考资料:

https://www.science.org/doi/10.1126/sciadv.adt3813

https://www.nytimes.com/2025/07/02/health/ai-chatgpt-research-papers.html