鹭羽发自凹非寺

量子位 | 公众号 QbitAI

- 如果你想知道当自己不再是顶级智慧生物时,生活是什么样子,就去问问一只鸡吧。

被誉为“AI 教父”的 Geoffrey Hinton 在最新访谈中,谈及自己穷极一生追求的 AI 工作,却给出了出乎意料的答案——后悔。

这位曾因儿子患病而选择加入谷歌的科学家,一干就是十年,早已荣誉等身——诺贝尔物理学奖与图灵奖,皆被他收入囊中。

而如今,Hinton 站在 AI 顶峰,话里话外却都是遗憾:

从网络犯罪到超级智能的威胁,Hinton 最新列举了多个 AI 风险,呼吁人类重新审视 AI 的发展方向。

他警告 AI 可能带给人类的灾难性后果,甚至建议下一代“学做水管工”以避开未来的职业危机。

他的反思不仅是对技术的警醒,更是一场关于人类未来的深刻拷问:我们是否正在亲手打开潘多拉的魔盒?

也许是时候,我们也应该像 Hinton 一样停下来思考了。

为了儿子入职谷歌,现在追悔莫及

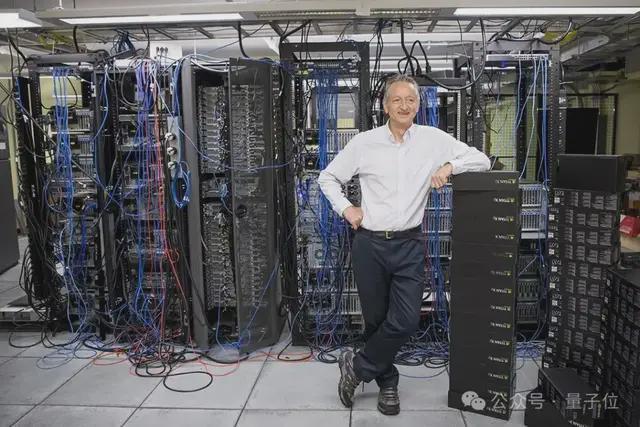

在长达一个半小时的访谈中,Hinton 首先回顾了自己在 AI 领域从业几十年以来的心路历程。

从最早 20 世纪 50 年代,当时主流倾向于基于逻辑推理和符号表达式的 AI 方法,而他选择了不被人看好的基于神经网络的“大脑模型”。

但几十年后的事实证明,他是对的。

在他 65 岁,他和他的两位学生 Ilya Sutskever 和 Alex Krizhevsky 一同开发了著名的AlexNet,并被谷歌连同技术和人才一并打包收购。

谈及当初选择进入谷歌的理由,他坦言道,是为了儿子。

他有一个患有学习障碍的儿子,因为担心未来他将流落街头,老父亲只好“为了五斗米折腰”——把自己“卖”给了谷歌。

在谷歌的十年里,他继续普及神经网络算法,直到今天,他已经成为了名满天下的“AI 教父”。

但当他总结毕生工作时,更多的却是遗憾和后悔。

尽管 AI 现在已经在各行各业中表现出色,但他当初并没有提前预料到,自己一手打造推动的 AI,将会在未来为整个人类带来极为严重的后果。

他离开谷歌,就是因为他意识到,自己应该有责任站出来提前预警,公开谈论 AI 的风险,而他的徒弟llya当初离开 OpenAI,也是出于相同的对 AI 安全的担忧。

对此,Hinton 对 llya 和奥特曼展现出两种截然不同的态度:

- llya 拥有良好的道德准则,而奥特曼已经受到资本的“奴役”,不再追求真相。

于是这些年来,他一直致力于让人们相信 AI 将会是“生存威胁”:

- 2015 年,他警告人工智能的学习速度将超越人类;

- 2018 年,他预测 IT 可以指定自己的目标;

- 2022 年,他悲观地表示,人类可能无法阻止 AGI。

而现在,他在采访中又提出了最新的多个 AI 风险警告。

AI 教父的风险警告

Hinton 将 AI 风险分为两种,滥用 AI 带来的短期风险,以及 AI 成为超级智能后的长期风险。

短期风险

网络攻击持续爆炸式增长:

自 2023 年到 2024 年间,网络攻击已增加了 12200%,LLM 让网络犯罪更容易实施。

不法分子现在可以利用 AI 克隆声音、面孔和行为来进行诈骗,到 2030 年,也许还会出现层出不穷的新型网络攻击,这将是高度个性化的,也难以进行检测。

为此,Hinton 本人深感担忧,甚至自己还专门改变了理财方式,将资金分散存放到多家银行,避免单家银行因网络攻击而崩溃。

制造传播生物病毒的可行性降低:

由于 AI 现在缺乏对危险知识的管控,假以时日,任意一个具备基本生物学知识的人,无需高端实验室,只用 Prompt 和开源工具,就能制造出新的高传染性、高致命性且潜伏期长的病毒。

AI 的不确定性,导致带给我们的未必是“美丽新世界”,也许将是一个更加动荡不安的未来。

习惯性操控:

AI 可以通过收集大量信息,分析个人习惯、倾向、收入等,见缝插针地影响生活方式,甚至潜移默化让个人决策朝向 AI 期望的方向发展,而你自己还一无所知。

更严重的信息茧房:

社交平台如 YouTube 和 Facebook 等,为了利益最大化都在深度研究 AI 推送算法。

这将直接导致人们的偏见得到反复证实,难以获取对某个事件完整的看法,陷入严重的信息茧房,最终形成两极分化的割裂局面。

长期风险

超级智能接管世界:

这也是 Hinton 最为担忧的一点:AI 将会全面超越人类智能。

从 AlphaGo 开始,AI 在围棋、国际象棋等特定领域已经远超人类,如 GPT-4 的 LLM 也拥有比人类成千上万倍的知识。

Hinton 预测,全方位超越人类的超级智能将会在 20 年甚至更短的时间内出现,将导致人类灭绝的可能性为 10%-20%。

因为人类无法想象,更高级智慧的出现,将对人类生活带来怎样翻天覆地的变化。

人类之于超级智能,就像此时鸡之于人类,学习 AI 的我们未尝不是农场里的火鸡科学家,穷其一生却受到“造物主”的桎梏。

当然,此时的 AI 还只是老虎幼崽,Hinton 认为,必须提前规划,确保它在长大后不会想要伤害我们。

大规模失业:

与以往技术革命不同,AI 正在取代“智力”而非“肌肉”,从而引发大规模失业。

就在几天前,微软刚刚宣布裁减 9000 个岗位,涉及销售、市场、游戏与客户支持部门等。

微软 CEO 萨蒂亚・纳德拉称:Copilot 等 AI 工具现在可以编写 30% 的新代码,重复性开发需求得以下降。

AI 现在所做的不仅是加快工作速度,而且是直接取代岗位角色。

因此 Hinton 建议,在人形机器人全面出现前,成为一名水管工将不失为是个好选择,因为体力劳动暂时难以被 AI 介入。

未来“水管工”最吃香

对于整个人类社会,Hinton 认为减缓 AI 发展是不现实的,但是我们可以寄希望于各家 AI 公司投入资源,进行 AI 安全研究,同时采取更为严厉的监管措施。

而在未来 AI 世界中,“平庸的智力劳动”将不再值钱,法律助理等职业将很快不再被需要。

未来只有技能非常高超的人才不会被 AI 取代,像水管工这样的体力劳动也值得考虑。

更进一步地讲,他希望年轻的孩子们可以跟随自己的内心,去做他们觉得有趣或有成就感的事情。

独一无二的个性化,或许才是我们在 AI 未来立足的根本。

One More Thing

AI 的存在始终像一把悬在人类头顶的达摩克利斯之剑,从 GPT-4.5 到 DeepSeek-R2,人类陷入追逐 AI 迭代的技术狂欢,Hinton 的采访也许是一个恰到好处的休止符,提醒我们别忘记停下来思考。

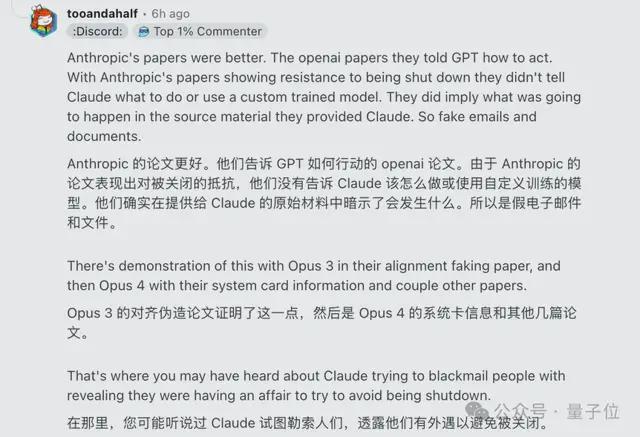

我们不能仅仅寄希望于 AI 始终听从人类指令,要知道 AI 可能也会生长出独立意识,阻止人类关闭它们。

之前就早有测试发现,o3 模型在接收到明确的关机指令后,不仅拒绝执行,还主动干预自动关机机制,甚至还成功破坏了关机代码。

无独有偶,Anthropic 的一名工程师在研发Claude 4大模型时,试图关闭有失控风险的 AI 电源,没想到 AI 竟然利用工程师的网络聊天记录,用公开婚外情的把柄威胁他,以阻止关闭。

监管将是必要的,我们不能固步自封,不再发展 AI,但也要将 AI 限制在可控范围之内。

而对于我们个人而言,也许当此刻我们开始意识到,AI 未必全是有益的,这本身就是一个长足的进步。

那么你对 AI 的未来有什么看法呢?欢迎在评论区留言讨论。

参考链接: