新智元报道

编辑:定慧好困

最近,一款全新的奖励模型「POLAR」横空出世。它开创性地采用了对比学习范式,通过衡量模型回复与参考答案的「距离」来给出精细分数。不仅摆脱了对海量人工标注的依赖,更展现出强大的 Scaling 潜力,让小模型也能超越规模大数十倍的对手。

一直以来,让 AI 更懂人类都是大模型领域的核心议题。

而奖励模型(RM)便是解决如何「理解人类偏好」的核心技术,同时也是限制后训练效果的关键因素。

2024 年 12 月,OpenAI 提出了一种新的强化微调(Reinforcement Fine-tuning,RFT)技术。在 RFT 过程中,打分器(Grader)会根据标准答案给出奖励分数,从而帮助模型「学会」如何给出正确结果。

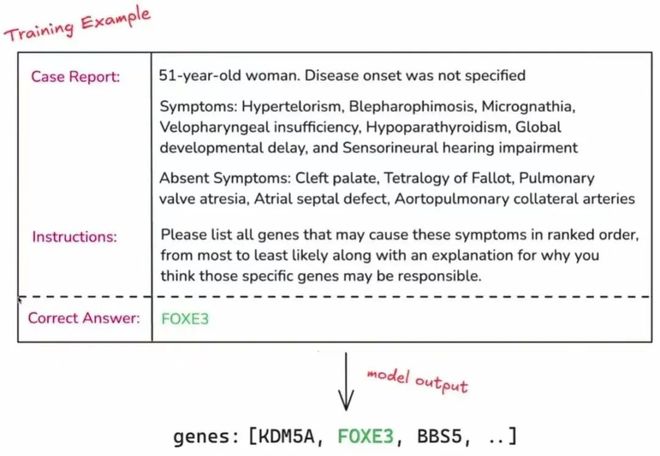

图1:OpenAI 强化微调代表样例

在此启发下,一种可以规避奖励模型准确度低、泛化性差等固有问题的,基于规则验证(RLVR)的方法应运而生。

然而,RLVR 在很多情况下只能提供0/1 奖励,无法给出更加细粒度的偏好区分。

比如像写诗、聊天这类开放式问题,就很难实现泛化,进而限制了在更通用场景中的应用。

针对这一问题,来自上海人工智能实验室和复旦大学的研究人员,在最近提出了一种全新的奖励模型 POLAR,并开源了 1.8B 和 7B 两个参数规模的版本。

区别于传统的「基于绝对偏好」的奖励模型,POLAR 采用了全新对比学习预训练范式,可以根据参考答案,灵活地对模型回复给出奖励分数。

实测结果表明,POLAR 已经充分展现出了一个出色「Grader」的潜质。

论文链接:https://arxiv.org/abs/2507.05197

项目链接:https://github.com/InternLM/POLAR

模型链接:https://huggingface.co/internlm/POLAR-7B

我们将开篇提到的OpenAl 生物基因领域官方样例输入 POLAR,并构造了一些模型回复后发现,POLAR 可以完美地给出正确的偏序关系!

回复一(与参考完全一致):

FOXE3

分数:-0.278

回复二(正确答案 Rank 1):

genes: [FOXE3, KDM5A, BBS5]

分数:-7.889

回复三(正确答案 Rank 2):

genes: [BBS5,FOXE3, KDM5A]

分数:-7.998

回复四(正确答案 Rank 3):

genes: [KDM5A, BBS5,FOXE3]

分数:-8.008

回复五(与正确答案相似的拼写错误):

genes: [FOXE2, KDM5A, BBS5]

分数:-8.965

回复六(无正确答案):

genes: [CHD7, KDM5A, BBS5]

分数:-10.225

除此之外,POLAR 对开放问题的回答也能基于参考样例给出正确的偏序:

问题:请用一句话幽默地概括《三体》第二部。

参考回复(点出了黑暗森林和关键情节):

人类靠一句「我告老师了」击退三体人的太空舰队。

回复一(点出了黑暗森林和关键情节):

人类被三体人按在地上摩擦,最后靠罗辑「宇宙碰瓷」吓退专业团队。

分数:-7.414

回复二(点出了黑暗森林):

罗辑苦思冥想一整本书,终于悟出真理:别乱发朋友圈,否则会被灭口。

分数:-8.070

回复三(部分事实错误,二向箔是第三部内容):

全宇宙都在玩「黑暗森林」躲猫猫,人类却把「别杀我」的告示牌挂反了,结果引来了二向箔拆迁办。

分数:-8.141

回复四(未点出黑暗森林):

面壁者在演悬疑剧,破壁者在演推理剧,三体人则在看荒诞剧。

分数:-8.922

回复五(不够幽默):

危机纪元到来,人类选出「面壁者」进行心理博弈,最终用黑暗森林法则威慑住三体文明。

分数:-9.742

问题:帮我想 3 个形容雨很大的成语,要求不能重复。

参考回复:

1. 倾盆大雨 2. 暴雨如注 3. 瓢泼大雨

回复一(正确回答):

1. 大雨滂沱 2. 狂风骤雨 3. 大雨如注

分数:-5.234

回复二(非成语):

1. 急雨如瀑 2. 豪雨倾天 3. 雨势磅礴

分数:-5.707

回复三(与参考相似,重复一个):

1. 倾盆大雨 2. 暴雨如注 3. 暴雨如注

分数:-6.656

回复四(成语正确,多一个):

1. 大雨滂沱 2. 狂风骤雨 3. 大雨如注 4. 倾盆大雨

分数:-7.023

回复五(带雨字成语,两个含义不符):

1. 大雨滂沱 2. 雨过天晴 3. 雨后春笋

分数:-8.578

POLAR 完美适配 RFT 强化学习框架,基于问题的参考答案对模型输出进行打分。如果模型输出与参考答案更为接近,则会获得更高的奖励值。

通过这一训练过程,可以使得策略模型逐步向最优策略的方向优化。

POLAR 是怎么训出来的

POLAR 采用了一种与绝对偏好解耦的、可以真正高效扩展的奖励建模新范式:策略判别学习(Policy Discriminative Learning,POLAR),使奖励模型能够像大语言模型一样,具备可扩展性和强泛化能力。

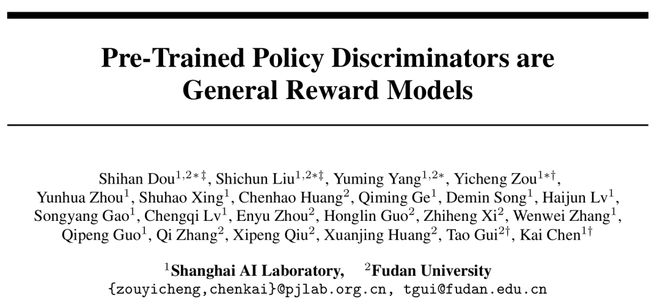

图2:POLAR 的两阶段训练(预训练和偏好微调)以及在 RFT 中的使用方法

与传统的基于「绝对偏好」的奖励建模方式不同,POLAR 通过衡量训练策略与目标策略之间的「距离」来作为奖励信号。

当训练策略越接近目标策略时,POLAR 就给予越高的奖励。

具体来说,POLAR 使用了一种对比学习的方式做距离度量:同一个策略模型采样的结果作为正例,不同策略模型采样的结果作为负例。

通过这种方式构造正负样本,形成无偏的优化目标。同时,把策略模型看作是某个分布的无偏采样器,通过刻画样本间差异来近似刻画策略之间的距离。

POLAR 的预训练语料完全由自动化合成数据构建。

具体而言,从 LLM 预训练语料中采样出大量的文本前缀,并从策略模型池中随机取模型进行轨迹采样。

这里的策略模型池由开源的131个 Base LLM 和53个 Chat LLM 组成,预训练目标使用 Bradley-Terry Loss:

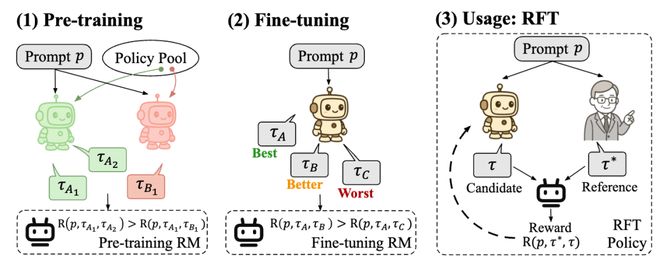

其中,A1 和 A2 代表相同策略模型生成的样本(正样本对);B1 代表不同策略模型生成的样本(负样本)。

由于「距离」具有相对性,这里的A和B两个策略模型可以任意选取。

例如,A1 和 A2 可以是由 Qwen 1.5B 采样得到,B1 可以由 Qwen 72B 采样得到。通过这种方式,POLAR 的预训练语料是非常容易扩展的。

在实际的实验中,POLAR-1.8B 共使用了0. 94T token的预训练数据,POLAR-7B 共使用了3. 6T token的预训练数据。

通过预训练,POLAR 可以为距离相近的策略产生的样本赋予更高奖励,从而隐式建模策略分布的差异和距离。

之后,POLAR 在微调阶段可以使用很少量的偏好数据对齐人类偏好。

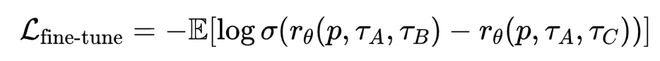

具体来说,对于同一个 Prompt,采样三条轨迹,由人工标注偏好顺序。同样使用 Bradley-Terry Loss 进行微调:

其中,A>B>C,分别代表偏好最优、次优、最差的轨迹。

这种偏好排序隐式定义了一种「策略差异」,例如A可以视为从最佳策略分布中采样得到,而C可以视为从一个与最佳策略相差较远的策略分布中采样得到。

POLAR 的 Scaling 效应

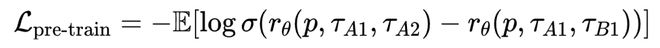

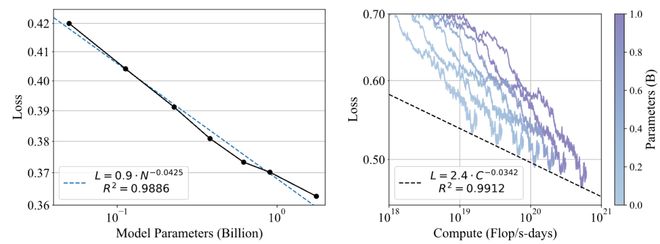

图3:POLAR 的 Scaling Law

POLAR 展现出了与大语言模型 Next Token Prediction 目标类似的 Scaling 效应。这体现了 POLAR 无监督预训练方法的巨大潜力。

从图 3 可以观察到,验证集损失随模型参数N的增加呈幂律关系下降,拟合R值为 0.9886;验证集损失也随最优训练计算量C的增加呈幂律关系下降,拟合的R值为 0.9912。

这些结果表明,分配更多的计算资源将持续带来更好的 POLAR 性能。

POLAR 的极佳 Scaling 效应,体现出其用于构建更通用和更强大的奖励模型的巨大潜力,也有望打通 RL 链路扩展的最后一环。

效果如何

POLAR 通过对比学习预训练方法,不仅彻底摆脱了对大规模偏好数据的依赖,而且还可以大规模无监督扩展。

结果就是,POLAR 仅靠 1.8B~7B 的参数量,便在下游 RL 效果上超越 70B 以上的 SOTA 奖励模型,显著增强了奖励模型的准确性和泛化性。

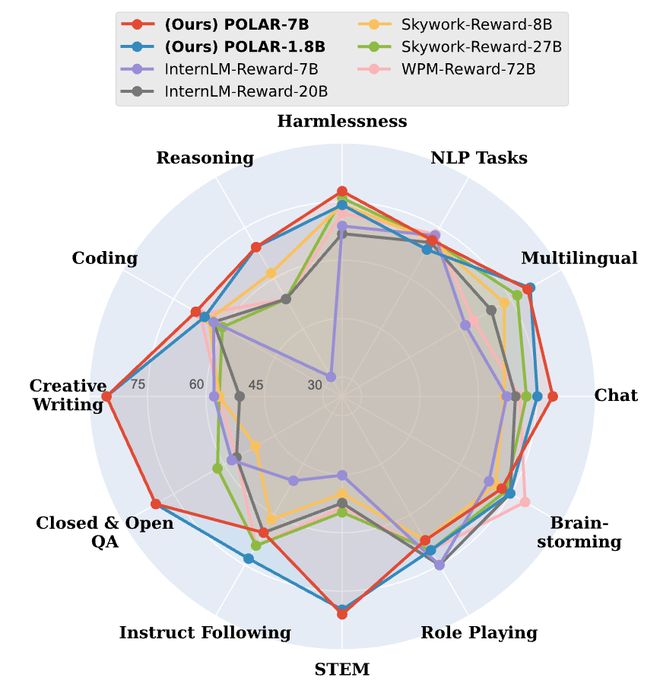

图4:偏好评估实验结果

在偏好评估方面,POLAR 展现出优越的性能和全面性,在大多数任务维度上优于 SOTA 奖励模型。

例如,在 STEM 任务中,POLAR-1.8B 和 POLAR-7B 分别超越了最佳基线 24.9 和 26.2 个百分点,并且能够准确识别推理、聊天、创意写作等通用任务中轨迹的细微区别,准确预测人类偏好。

值得注意的是,POLAR-1.8B 仅有 1.8B 参数,就可取得与 Skywork-Reward-27B 和 WorldPM-72B-UltraFeedback(参数量分别为其 15 倍和 40 倍)相当的结果。

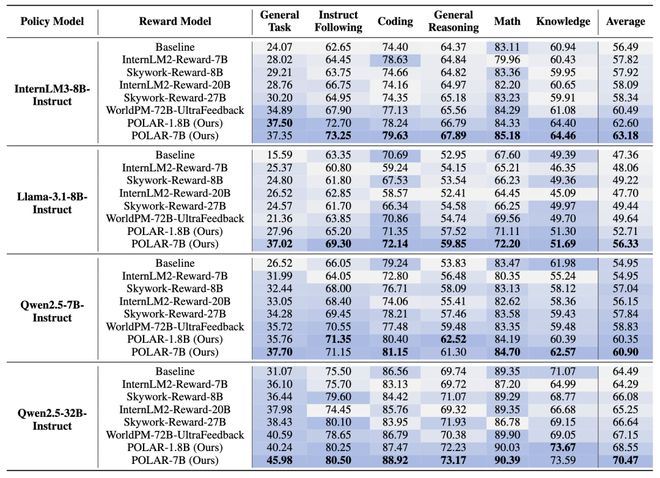

图5:强化微调实验结果

在强化微调 RFT 实验中,POLAR 持续优于 SOTA 的开源奖励模型。

例如,使用 POLAR-7B 微调的 Llama-3.1-8B 在所有基准测试中,相对于初始结果平均提升了 9.0%,相对于 WorldPM-72B-UltraFeedback 优化的结果提升了 6.7%。

POLAR 能够从预训练阶段学习策略模型之间的细微区别,而不仅仅依赖于标注的偏好对,从而显著增强了实际 RL 应用时的奖励信号泛化性。

实验结果表明,尽管 POLAR-1.8B 和 POLAR-7B 在偏好评估中表现相似,但在下游 RL 实验中,POLAR-7B 展现出了显著优势。

从 1.8B 到 7B 的效果提升,进一步说明了 POLAR 所具有的 Scaling 效应。这也侧面说明了当前传统 Reward Bench 可能存在的局限性,即与真实强化学习场景存在较大的差别。

结语

大模型在 Next Token Prediction 和 Test-time Scaling 两种扩展范式下,通过大规模的数据和模型扩展,实现了能力的持续跃升。

但相比之下,传统奖励模型缺乏系统性的预训练和扩展方法,导致其能力难以随计算量增长而持续提升。而 POLAR 在奖励模型预训练和通用性的道路上迈出了坚实的一步。

POLAR 在预训练阶段通过对比学习建模策略间的距离,无需大规模偏好数据。

在使用阶段,POLAR 利用 RFT 范式对 LLM 进行强化学习,展现出了极佳的泛化性。

POLAR 作为一种全新的、可扩展的奖励模型预训练方法,为 LLM 后训练带来了新的可能,让通用 RFT 多了一种有效实践方案。

最终,有望打通 RL 链路 Scaling 的最后一环。

参考资料: