新智元报道

编辑:海狸

Google 双线出击!T5Gemma 重燃 encoder-decoder 架构战火,性能暴涨 12 分;MedGemma 坚守 decoder-only 路线,强攻医疗多模态,击穿闭源壁垒。Gemma 体系完成「架构+落地」双重进化,打响 Google 开源反击战。

2023 年以来,大模型的战场由 decoder-only 架构一统江湖。

从 GPT 家族到 LLaMA、Gemma、Mistral,再到 Claude、Command-R、Yi 系列,

能叫得出名字的主流 LLM,几乎都是清一色的「纯解码器」(decoder-only)。

但今天,Google 带着 T5Gemma 杀回来了——

不仅重启了 encoder-decoder 的技术路线,还略施小技就让它原地起飞,暴打原版 Gemma 2。

T5Gemma 本身基于 decoder-only 的 Gemma 2 框架。

神奇的是,通过简单的「适配」转换成 encoder-decoder 架构后,T5Gemma 一举实现性能飞跃。

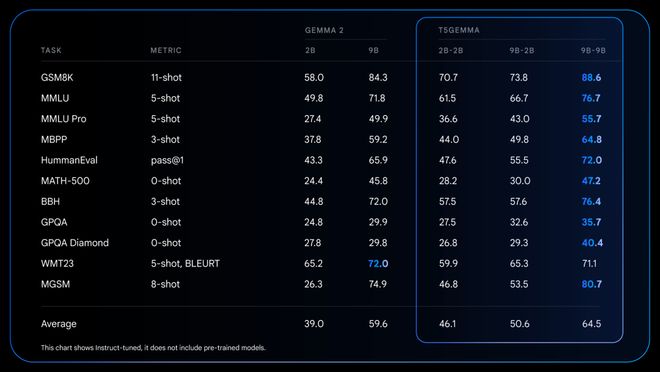

T5Gemma 9B-9B 在 GSM8K(数学推理)上得分⽐原始 Gemma 2 9B⾼出 9 分,在 DROP(阅读理解)上⾼出 4 分。

进一步缩小参数量,结果反而更惊人!

T5Gemma 2B-2B IT 的 MMLU 得分⽐Gemma 2 2B 提高了近 12 分,GSM8K 准确率暴涨到 70.7%。

T5Gemma 主要面向文本生成任务,包括问答系统、数学推理、阅读理解等。

并且 encoder-decoder 的架构支持「不平衡」配置。如 9B 编码器配 2B 解码器,可以在质量和效率之间游刃有余。

在相同的计算量下,T5Gemma 性能优于仅解码器模型,灵活度也更胜一筹,可以根据具体任务调整编码器和解码器的大小。

除了 Gemma 2 的技术回马枪之外,Gemma 3 系列也有重大更新!

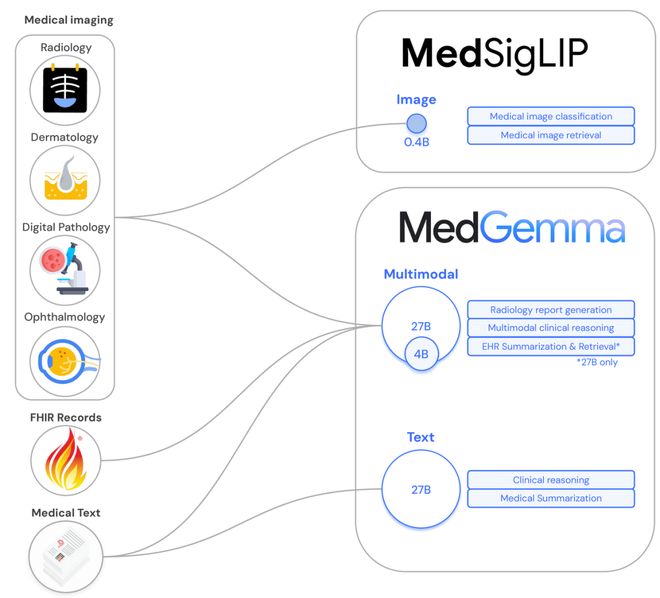

Google 这次专攻医疗多模态任务,基于 Gemma 3 架构,推出了 MedGemma 和 MedSigLIP 两款多模态模型。

MedGemma 支持图文输入,输出是医学自由文本;MedSigLIP 则是轻量图文编码器。

Google 把「低资源友好」贯彻到底,MedGemma 仅需 4B 模型即可逼近 SoTA,部署门槛极低,单卡、甚至移动端也能轻松跑起来。

4 亿参数的 MedSigLIP 也是全能王者,不仅擅长医学图像,检索、零样本分类等非医学下游任务也手拿把掐。

在 Med 系列「开源双子星」的轰炸下,医疗模型闭源壁垒岌岌可危,同行纷纷对 Google 表示祝贺和期待。

「架构+落地」双王炸,Google 的开源 LLM 体系战略杀疯了。

四两拨千斤

重燃 encoder-decoder 架构之战

T5Gemma 基于 Gemma 2 框架,包括适配后的 Gemma 2 2B 和 9B 模型,以及⼀组新训练的 T5 尺寸模型(Small、Base、Large 和 XL)。

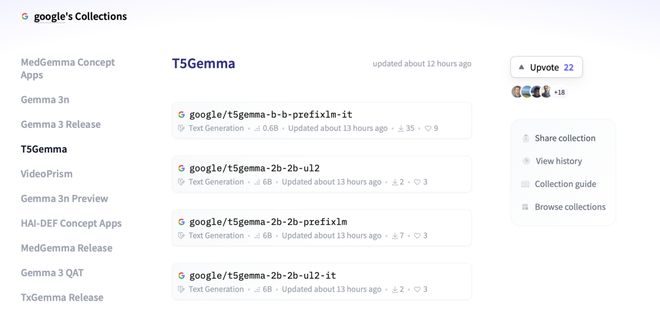

Google 已经将预训练模型和指令微调模型的 T5Gemma 系列在 huggingface 上开源,助⼒社区在研究与开发中挖掘新的机会。

一招适配,暴打原版

不少网友在 T5Gemma 发布后纷纷表示,encoder-decoder 其实也具有很强的输入理解、上下文建模和推理能力。

然而,它却因为 decoder-only 架构的风头无两而被雪藏已久。

Google 四两拨千斤,仅凭一招「适配」,把 encoder-decoder 架构重新带到聚光灯下。

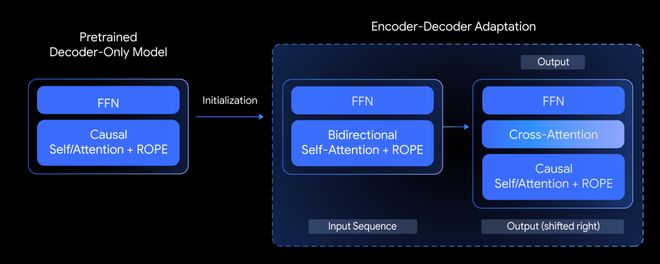

在技术报告中,Google 所提出的「模型适配」(Model Adaptation)理念其实非常直观:

直接利用已完成预训练的 decoder-only 模型权重,初始化 encoder-decoder 模型的参数,然后基于 UL2 或 PrefixLM 进行进一步训练。

具体而言,如图所示。

Google 首先使用一个已经预训练完成的 decoder-only 模型,比如 Gemma 2 9B 或 2B。

这个模型包含前馈网络模块(FFN)和一个因果自注意力+旋转位置编码(ROPE)模块

原本 decoder-only 模型中的「因果自注意力」模块会被替换为「双头注意力」以适配 encoder。在 encoder 中,FFN 和 ROPE 参数继续沿用原模型。

原始 decoder-only 中的模块中间新增一层 Cross-Attention 之后,作为新架构的 decoder,用于解码器从 encoder 输出中获取信息。

在上述结构完成初始化后,模型可以使用 UL2 或 PrefixLM 来适应 encoder-decoder 的信息流、masking 策略和解码方式。

这种适配⽅法具有很⾼的灵活性,允许在模型尺寸之间进⾏创造性的组合。

想法简单,效果惊人

实验证明,T5Gemma 的想法非常有效。

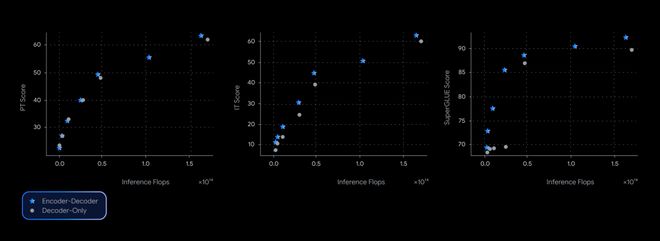

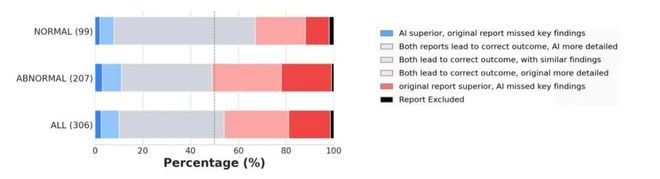

在相同的推理 FLOPs 下,T5Gemma 的表现(星形点)始终高于或等于 decoder-only 模型(圆形点)。

在 SuperGLUE 基准上,T5Gemma 的最高分超过 90,显著领先于大多数 decoder-only 模型。

IT(信息提取)与 PT(推理任务)指标同样展现出 encoder-decoder 架构的稳健性,特别是在中低 FLOPs 区间内性能提升尤为显著,说明它对计算资源的利用效率更高。

在真实场景下,T5Gemma 的高效计算优势也一路狂飙,稳坐开源性能「性价比之王」。

以 GSM8K(数学推理)为例,T5Gemma 9B-9B 的准确率⾼于 Gemma 2 9B,但延迟却相近。

T5Gemma 9B-2B 在准确率上远超 2B-2B 模型,但其延迟却几乎与较⼩的 Gemma 2 2B 模型相同。

全方位碾压!T5Gemma 不止于快

T5Gemma 在预训练前后都展现出强⼤能⼒。

例如,T5Gemma 9B-9B 在 GSM8K(数学推理)上得分⽐原始 Gemma 2 9B⾼出超过 9 分,在 DROP(阅读理解)上⾼出 4 分。

这些提高意味着,通过「适配」进行初始化的 encoder-decoder 架构潜力更大。

进行指令微调后,Gemma 2 与 T5Gemma 的性能差距在多个任务上进一步显著扩大。

T5Gemma 2B-2B IT 的 MMLU 得分狂超 Gemma 2 2B 近 12 分,GSM8K 准确率从 58.0% 跃升到 70.7%。

MedGemma

击破医疗 AI 开源壁垒

Google 这次盯上了医疗多模态场景,一口气发布两款模型:MedGemma 和 MedSigLIP。

Med 系列多模态模型延续了「低资源友好」的策略。

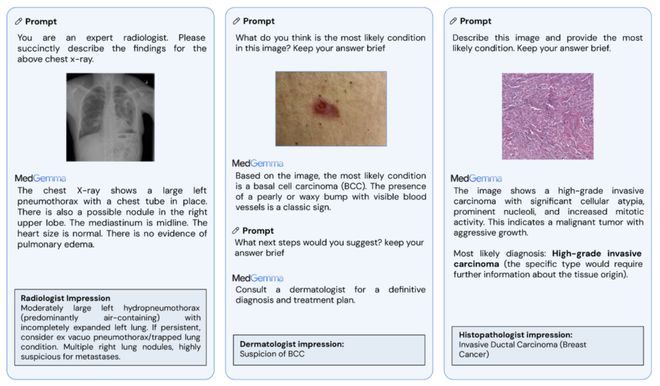

基于 Gemma 3 打造的 MedGemma 生成式多模态模型,支持图像+文本输入,输出医学自由文本。

该模型提供 4B 和 27B 两种尺寸,4B 多模态版本可在单卡甚至移动设备上运行,一举把医学级模型推下了高算力「神坛」。

不管是放射报告生成,还是图像问答和病例摘要,它都能轻松胜任。

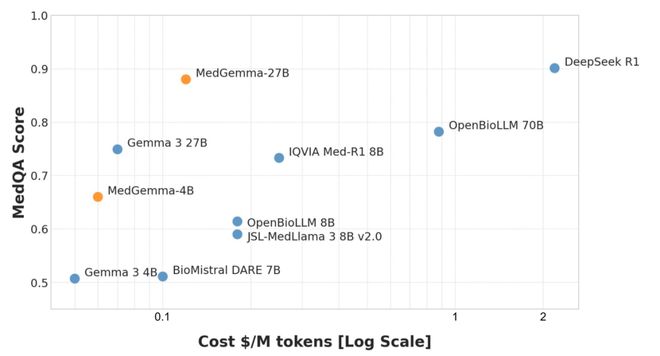

在 MedQA 等权威评测中,MedGemma 27B 拿下 87.7% 高分,精度接近 DeepSeek R1,但推理成本仅为十分之一!

图文编码器 MedSigLIP 更加短小精悍。

只有 4 亿参数,却能稳稳处理胸片、皮肤病、眼底等多种医学图像,并输出与文本对齐的语义嵌入。

图像分类、零样本识别和语义图像检索,统统一「模」搞定。

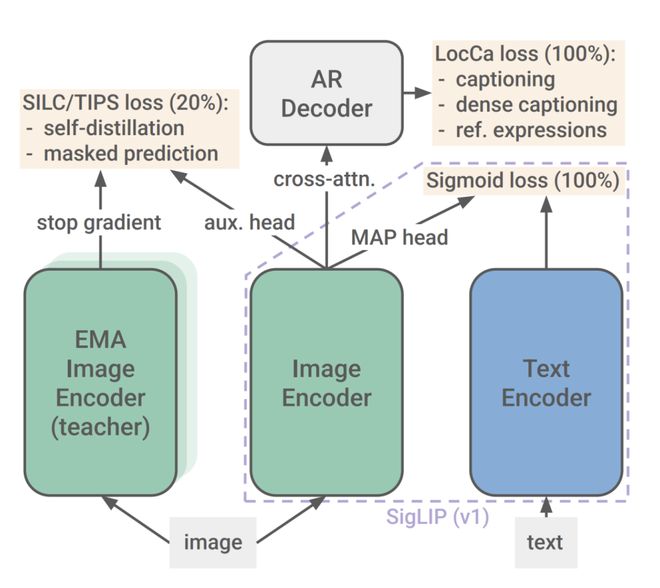

在开发过程中,团队首先把 MedSigLIP 训了出来,作为医学优化图像编码器。

然后在医学数据上训练了 4B 和 27B 版本的 Gemma 3 模型。

通过训练流程解耦,Gemma 3 很好地保留了通用能力。MedGemma 在融合医学与非医学信息、遵循指令、支持非英文语言等任务上依然表现良好。

单独训出来的 MedSigLIP 是一款仅 4 亿参数的轻量医学图像编码器,采用 Sigmoid 损失的 SigLIP 架构,如下图所示。

它的训练是通过胸片、病理切片、皮肤病图像与眼底图像等多样医学图像数据调优完成的。

MedSigLIP 的核心目标是,将医学图像与文本编码为「同一语义空间嵌入向量」。

它在多种医学图像任务中的分类效果可媲美专用模型,同时通用性也不拜下风,完美胜任传统图像分类、零样本分类、检索等任务。

Gemma 路线大升级

Google 开源吹响反攻号角

Google 这波开源一举把「反攻号角」吹到了医疗 AI 最前线。

无论是图文融合的 MedSigLIP,还是医疗多语种全能选手 MedGemma,全都以 safetensors 格式上线 Hugging Face,直接拉低使用门槛。

开发者可以一键下载、灵活部署,还能在本地或自定义云平台完成推理与微调,隐私合规和数据安全轻松搞定。

不少医疗机构已经验证了 Med 系列医疗 AI「开源双子星」的有效性。

例如,美国 DeepHealth 已开始使用 MedSigLIP 优化胸片分诊与结节检测;台湾长庚纪念医院称 MedGemma 能很好理解繁体中文医学文献,并有效回应医护问题。

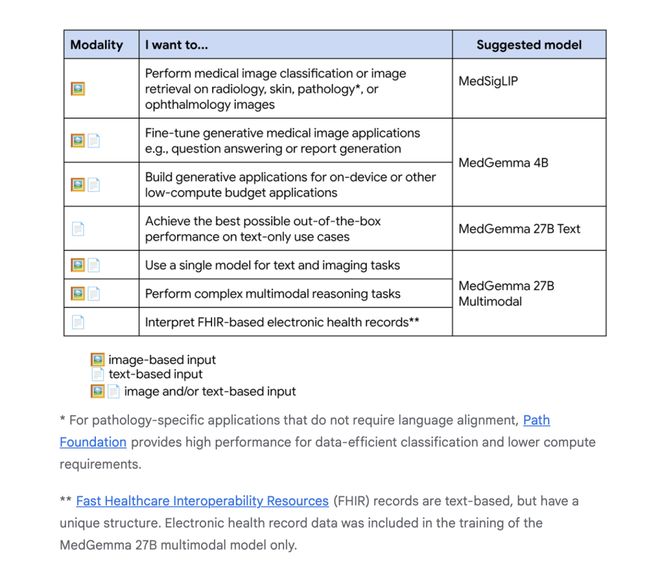

对于医疗机构的不同需求,Google 还给出了对应的模型选择建议。

Hugging Face 上已经提供了 32 个版本的 T5Gemma 全家桶。

用户可以根据推理速度、内存预算、精度等个性化需求,自由选择模型型号,也可以选择预训练版、指令微调版、RLHF 版,或基于不同目标(PrefixLM / UL2)训练的各种变体。

不止如此,Google 还贴心给出全套使用手册、Colab 示例和 Vertex AI 部署方案,从下载到上线一路畅通,开发效率直接拉满。

Gemma 路线已经从「架构革新」延伸到「产业落地」。

Google 这波上场更新,不止打破了闭源神话,更是为整个 AI 社区作出了「工具+自由+性能」的表率。

从 T5Gemma 到 MedGemma,世界级开源模型已来,接下来,是开发者的上场。

参考资料:

https://developers.googleblog.com/en/t5gemma/

https://research.google/blog/medgemma-our-most-capable-open-models-for-health-ai-development/