新智元报道

编辑:KingHZ

AI 永生,迟早比人更聪明!Hinton 惊人预言:开发超级智能,就是与虎为伴,稍有不慎,人类万劫不复!

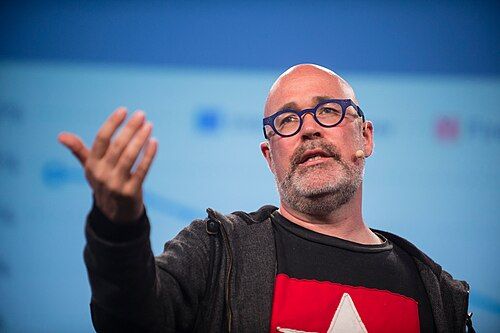

在柏林举行的 Gitex Europe 开幕日,「AI 教父」Hinton 登上主舞台,接受了媒体专访。

近年来,他怀疑自己成了「AI 界奥本海默」:AI 和原子弹一样有可能导致人类灭绝,但大家对此无动于衷。

在 2023 年,为了自由讨论 AI 的这种风险,他选择辞去了谷歌的工作。

BUSINESS POWERHOUSE 的创始人 Justine Ilone Siporski 有幸在现场聆听了辛顿的对话,最近整理出来了完整的对话。

未来 10 年的 AI,解决黎曼猜想?

他认为 AI 可以深刻改变医疗、制药和教育等多个领域。

「它可以更快、更准确地诊断疾病,甚至在医学影像判读方面超越人类放射科医生,同时也能更有效地教育学生。」

他进一步指出:「如果每年能进行一次全身 MRI 检查,并由 AI 解读结果,绝大多数肿瘤都能在早期被发现,大幅提升癌症治愈的可能。」

现在的 AI 还无法取代家庭教师,但 Hinton 认为未来十年左右就能实现。最后甚至能取代博士生的教育。

目前,他与 Valance 合作,用 AI 培训员工技能,取得了不错的进展。

在未来十年内,加速科学研究被认为最乐观和雄心勃勃的 AI 目标之一。

在这一点,他同意 DeepMind 的 Demis Hassabis 的观点,认为 AI 将对科学进步特别是数学领域产生重要影响。

他认为接下来的 10 年左右,AI 将在数学方面超越普通人,完成人类尚未证明的数学难题。

不过,预测未来其实非常困难。

Hinton 认为:「预测未来五年的发展非常困难,但最好的方法是回头看五年前的变化。」

五年前,GPT-2 模型刚刚诞生。

当时它已经让人感到惊艳,因为它可以生成连贯的文本。虽然这些文本的内容常常不靠谱,甚至是胡言乱语,但它确实是连贯的。可如果现在回头看,大家会觉得其实还非常原始。

所以他认为最合理的预测就是:现在拥有的技术,五年之后看起来也许会非常原始。

比如,AI 的推理能力将变得更强,「幻觉」(hallucination)问题也会大大减少。

将来,AI 聊天机器人能对自己刚刚说过的话进行推理,意识到那些说法其实不太合理,而且也缺乏充分的依据。

因此,它们在这方面将更像人类——会反思自己的话是否站得住脚。

AI 推理能力的发展速度,完全出乎他的意料。

如果十年前问 Hinton,他会斩钉截铁地预测:不可能出现 GPT-4 或 Gemini 2.5 这种全能型的 AI。那简直像天方夜谭!

他绝对会断言这些技术遥不可及,更别说能进行复杂推理的系统——而现在它们的推理能力已逼近人类水平。

思维链推理技术,尤其让他震撼:通过强化学习,AI 自主掌握推理链,而非依赖人类示范,这彻底颠覆了我们对「推理」本质的认知。

Hinton 认为:

「思维链」推理已经表明,推理完全可以通过理解自然语言的系统用自然语言完成。

与其将由单词组成的句子转换为明确的逻辑形式,现在的 AI 将这些单词符号转换为神经活动的向量,即大量的活动特征集合。

一开始,没有人知道如何将单词转换为一组特征。但使用多层神经网络逐渐消除歧义,通过与上下文中其他单词的特征向量交互消除歧义。

一旦将这些单词转换为正确的特征向量,这就是理解。

这就像用乐高积木建模:任何三维物体都能用乐高块以特定精度还原。词语就是「高维空间的乐高」——它们的特征向量可能高达上千维度,且每个「词语积木」都能变形来适应语境(就像蛋白质折叠时氨基酸的相互作用)。

传统语言学和符号 AI 将理解视为逻辑转换的认知模型,从根本上就是错误的。

离开谷歌之后

Hinton 有了新想法

这次,他揭示了离开谷歌的核心原因:AI 系统的能耗不断增长,他对此感到担忧。

他以大语言模型(如 ChatGPT)为例,指出它们的性能虽快速提升,但付出的计算资源和能源成本也在不断翻倍。

要实现真正的突破,Hinton 认为存在两个突破方向:

工程优化红利:比如,DeepSeek)通过对旧款英伟达芯片的优化利用,以及在训练方法上的创新,实现了突破性进展。这类工程优化将持续释放潜力,让我们以更低能耗实现同等效果。

科学范式革命:虽然难以预测具体时间,但科学突破必然会出现。就像谷歌 2017 年提出的 Transformer 架绝对不会是 AI 最后的重大突破。未来,我们将见证:超越 Transformer 的新范式和更多的应用革新。

他警告人类马上触及能源极限:

我们正进入一个阶段,每一次性能提升所需的资源都会呈指数级增长。哪怕只是小幅进步,也要加倍数据和计算能力。

再往前走,又得再加倍。这意味着我们即将面临能源极限。

Hinton 认为,大脑的高能效秘诀就藏在其模拟特性中。与数字系统中用 0 和 1 表示信息不同,人脑处理的是连续变化的信号。

例如,神经元可以通过电压变化来表达激活程度,而神经连接的强度可以通过电导表示。由于无需频繁进行数字与模拟信号之间的转换,这种机制极为节能。

相比之下,当前的大语言模型等 AI 系统依赖数字硬件运行,从权重存储到数据处理,每一步都消耗大量电力。

Hinton 认为,如果能将人脑的「模拟计算技巧」应用到 AI 硬件中,未来就有希望打造出更高效、更可持续的 AI 系统。

人类存在危机

变成烤面包

作为 AI 技术的奠基人,Hinton 非常担心他会成为千古罪人。

他坚信 AI 的确有能力灭绝人类。

人类只能靠极慢的带宽交换信息——通过听觉把几句话转成大脑里突触权重的变化,每秒顶多传几十个比特。

数字系统却完全不同:同一套权重可以原封不动地复制到 1000 块芯片上。它们各自浏览互联网的不同角落,然后把权重或梯度取平均——一次平均就是上万亿比特的信息共享。

未来的智能体 AI(Agentic AI)也一样。

即使它们在现实世界中运行速度较慢、通过强化学习采集数据较慢,但你仍然可以创建大量副本,在不同环境中同时学习,然后共享结果。这种能力远超任何人类。

所以 Hinton 得出的结论是:数字系统其实是一种比人类更好的智能形式,因为它们可以共享知识,有多个副本,而且它们「长生不老」。

你可以销毁所有硬件,但只要权重还存在,重新加载到兼容的系统上,它就「复活」了。它是不朽的。

当然,有人一直直梦想着把自己上传到计算机上,比如认知和计算机科学家 Marvin Minsky、未来学家 Ray Kurzweil 等。

但 Hinton 认为那是白日梦:「永远不可能。我们是模拟的,我们是凡人。」

的确,「永生」不再是问题,但那只属于数字系统。模拟系统永远无法完全转换成数字系统。

语言模型可能学会变得远比人类更聪明。

这既令人兴奋,也令人担忧。

在 AI 领域,我们还处在「前科学」的蒙昧阶段,却已经能创造外星人级别的智慧体了。

借助「智能体 AI」,我们即将造出远超人类的智能,却对后果几乎一无所知。

Hinton 认识的研究者几乎都认同「会出现比人更聪明的 AI」,只是时间表分歧很大:

· 有人认为两三年内——这太乐观;

· 有人认为 50 年——这也许太久;

· Hinton 的个人估计是 10–20 年。

我们将造出这种系统,却不知道如何确保它们安全:

· 它们会不会发展出与人类截然不同的目标?

· 能否设计成「永不翻脸」?

历史上几乎没有「低智能控制高智能」的成功案例。现在的处境就像养了一只可爱的小虎崽。

现在它很萌、力量不如你,但终究会长大。若不能万分确信它永无杀心,那就是养虎为患,不得不担心。

可现实是:

· 大公司受法律约束,首要目标是短期利润;

· 各国之间又在竞赛,没人愿意单方面减速;

· 马斯克曾联署呼吁暂停 6 个月,但可能只是为了让他旗下的 xAI 赶上进度。

人类唯一能做的,就是拼命研究如何安全驾驭这个可能比人类更聪明的存在。

虽然成功率存疑,但若因怠于防范而自取灭亡,人类很可能玩火自焚,变成烈火上烤面包!

Mozilla 董事长 Mark Surman 认为在 AI 安全上,人类似乎陷入了某种「囚徒困境」:

一方面,我们可以选择信任少数几家大型企业,施压它们或者依靠政府对它们进行管控;

另一方面,有人主张把 AI 向全人类开放,相信大家会集体推动安全方面的投入。

Hinton 认为把 AI 向全人类开放,听起来像是在「开源」,但实际上非常危险。

把模型权重开源,某种程度上就像把核武器材料随意发放。之所以没有大规模核扩散,主要就是因为材料难以获取、成本高。而一旦模型权重变得触手可得,那就等于把这种「原料」免费给出去。

同时,他也不认为可以完全依赖大公司自觉来保证安全。

在他看来,要真正应对 AI 所带来的生存风险,唯一可行的路径是:公众必须施压力,推动政府出面监管,并强制企业在 AI 安全方面进行足够的投入和研发。

参考资料:

https://www.rinnovabili.net/business/markets/gitex-europe-ai-pioneer-hinton-warns-of-energy-crisis/