新智元报道

编辑:定慧好困

在 WAIC 2025 大会上,上海 AI 实验室首席科学周伯文和 Hinton 教授的尖峰对话轰动全场。而在科学探索上,实验室更是独辟蹊径开创「通专融合」大模型创新路线,全新一代科学大模型拿下多模态能力全球第一。

在人声鼎沸的 WAIC 2025 上,一款堪称「全能高手+科学明星」合体的大模型,由于在科学方面太优秀,反倒显得低调——但它的能力却无法被忽视。

它能精准解析分子结构、看懂地震波图、推演化学反应路径……

7 月 26 日,上海人工智能实验室(上海 AI 实验室)发布并开源「书生」科学多模态大模型 Intern-S1。

它不仅多模态能力全球开源第一,文本能力比肩国内外一流模型,科学能力全模态达到国际领先。

而且,作为融合科学专业能力的基础模型,其综合性能更是当前开源模型的最优。

-

在同一模型内,Intern-S1 实现了语言和多模态性能的高水平均衡发展,具备「全能高手」的实力;

-

作为「科学明星」,Intern-S1 富集了多学科专业知识,并重点强化了科学能力,在化学、材料、地球等多学科专业任务基准上超越了顶尖闭源模型 Grok-4;

-

Intern-S1 开创了「多任务的通专融合」的新范式,支持大规模多任务强化学习齐头并进,在保持能力全面的同时实现专业精通。

相比之下,传统的单一模态分析在科学发现过程中往往难以全面捕捉复杂现象,尤其是在跨学科领域的深度探索中更加显著。

Intern-S1 体验页面:

https://chat.intern-ai.org.cn/(点击文末阅读原文直达)

GitHub 链接:

HuggingFace 链接:

https://huggingface.co/internlm/Intern-S1-FP8

ModelScope 链接:

https://modelscope.cn/models/Shanghai_AI_Laboratory/Intern-S1

开源科学多模态

性能领先,重构科研生产力

Intern-S1 以轻量化训练成本,达成科学/通用双维度性能突破。

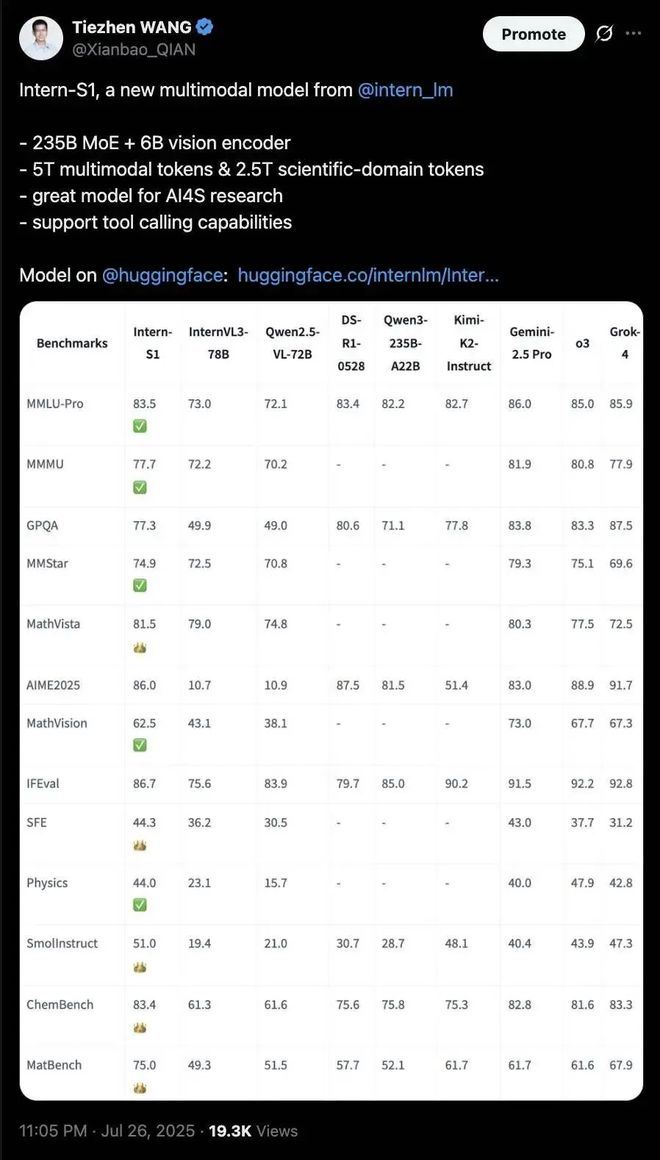

在综合多模态通用能力评估上,Intern-S1 得分比肩国内外一流模型,展现跨文本、图像的全面理解力。该评估为多项通用任务评测基准均分,证明其多场景任务中的鲁棒性与适应性,无惧复杂输入组合挑战。

在多个领域专业评测集组成的科学能力评测中,Intern-S1 领先 Grok-4 等最新闭源模型。评测覆盖了物理、化学、材料、生物等领域的复杂专业任务,验证了模型在科研场景的强逻辑性与准确性,树立行业新标杆。

当大模型在聊天、绘画、代码生成等场景中持续取得突破时,科研领域却仍在期待一个真正「懂科学」的 AI 伙伴。

尽管当前主流模型在自然语言处理、图像识别等方面表现出色,但在面对复杂、精细且高度专业化的科研任务时,依然存在明显短板。

一方面,现有开源模型普遍缺乏对复杂科学数据的深度理解,难以满足科研场景对精度、专业性和推理能力的严苛要求。

另一方面,性能更强的闭源模型存在部署门槛高、可控性弱等问题,导致科研工作者在实际应用中常面临高成本、低透明的现实挑战。

在 2025 世界人工智能大会(WAIC 2025)科学前沿全体会议上,上海 AI 实验室发布了『书生』科学多模态大模型 Intern-S1。

模型首创「跨模态科学解析引擎」,可精准解读化学分子式、蛋白质结构、地震波信号等多种复杂科学模态数据,并具备多项前沿科研能力,如预测化合物合成路径,判断化学反应可行性,识别地震波事件等,真正让 AI 从「对话助手」进化为「科研搭档」,助力全面重构科研生产力。

得益于强大的科学解析能力,Intern-S1 在化学、材料、地球等多学科专业任务基准上超越了顶尖闭源模型 Grok-4,展现出卓越的科学推理与理解能力。

在多模态综合能力方面,Intern-S1 同样表现亮眼,全面领先 InternVL3、Qwen2.5-VL 等主流开源模型,堪称「全能高手」中的「科学明星」。

基于 Intern-S1 强大的跨模态生物信息感知与整合能力,上海 AI 实验室联合临港实验室、上海交通大学、复旦大学、MIT 等研究机构协同攻关,共同参与构建了多智能体虚拟疾病学家系统——「元生」(OriGene),可用于靶标发现与临床转化价值评估,已在肝癌和结直肠癌治疗领域上分别提出新靶点 GPR160 和 ARG2,且经真实临床样本和动物实验验证,形成科学闭环。

体系化的技术创新为 Intern-S1 的能力突破提供了有效支撑。自书生大模型首次发布以来,上海 AI 实验室已逐步构建起丰富的书生大模型家族,包括大语言模型、多模态模型、强推理模型等。

Intern-S1 融合了『书生』大模型家族的优势,在同一模型内实现了语言和多模态性能的高水平均衡发展,成为新一代开源多模态大模型标杆。

Intern-S1 在国际开源社区引发了关注,不少开发者纷纷为其点赞,并称「几乎每天都能看到来自中国的新开源 SOTA 成果——纪录每天都在被刷新。」

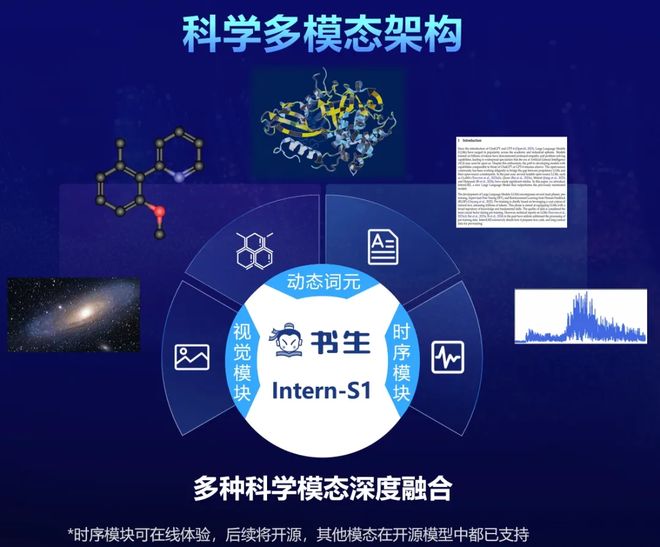

创新科学多模态架构让数据深度融合

受数据异构性壁垒、专业语义理解瓶颈等因素制约,传统的通用大模型在处理科学模态数据时面临显著挑战。

为了更好地适应科学数据,Intern-S1 新增了动态 Tokenizer 和时序信号编码器,可支持多种复杂科学模态数据,实现了材料科学与化学分子式、生物制药领域的蛋白质序列、天文巡天中的光变曲线、天体碰撞产生的引力波信号、地震台网记录的地震波形等多种科学模态的深度融合。

通过架构创新,Intern-S1 还实现了对科学模态数据的深入理解与高效处理,例如,其对化学分子式的压缩率相比 DeepSeek-R1 提升 70% 以上;在一系列基于科学模态的专业任务上消耗的算力更少,同时性能表现更优。

「通专融合」让单模型搞定多项专业任务

科学领域的高价值任务往往高度专业化,不仅模型输出可读性差,且不同任务在技能要求与思维方式上差异显著,直接混合训练面临此消彼长的困境,难以实现能力的深度融合。

为此,研究团队提出通专融合的科学数据合成方法:一方面利用海量通用科学数据拓展模型的知识面,另一方面训练众多专业模型生成具有高可读性、思维路径清晰的科学数据,并由领域定制的专业验证智能体进行数据质量控制。

最终,这一闭环机制持续反哺基座模型,使其同时具备强大的通用推理能力与多项顶尖的专业能力,真正实现一个模型解决多项专业任务的的科学智能突破。

联合优化系统+算法,成本直降 10 倍

当前,强化学习逐渐成为大模型后训练的核心,但面临系统复杂度和稳定性的重重挑战。得益于训练系统与算法层面的协同突破,Intern-S1 研发团队成功实现了大型多模态 MoE 模型在 FP8 精度下的高效稳定强化学习训练,其强化学习训练成本相比近期公开的 MoE 模型降低 10 倍。

在系统层面,Intern-S1 研究团队采用了训推分离的 RL 方案,通过自研推理引擎进行 FP8 高效率大规模异步推理,利用数据并行均衡策略缓解长思维链解码时的长尾现象;在训练过程中同样采用分块式 FP8 训练,大大提升训练效率。后续,训练系统也将开源。

在算法层面,基于 Intern·BootCamp 构建的大规模多任务交互环境,研究团队提出Mixture of Rewards 混合奖励学习算法,融合多种奖励和反馈信号,在易验证的任务上采用 RLVR 训练范式,通过规则、验证器或者交互环境提供奖励信号;在难验证的任务上(如,对话和写作任务)采用奖励模型提供的奖励信号进行联合训练。

同时,训练算法还集成了上海 AI 实验室在大模型强化学习训练策略上的多项研究成果,实现了训练效率和稳定性的显著提升。

工具链全体系免费开源

打造更懂科学的 AI 助手

书生大模型自 2023 年正式开源以来,已陆续迭代升级多个版本,并持续降低大模型应用及研究门槛。

书生大模型首创并开源了面向大模型研发与应用的全链路开源工具体系,覆盖数据处理、预训练、微调、部署、评测与应用等关键环节,包含低成本微调框架 XTuner、部署推理框架 LMDeploy、评测框架 OpenCompass、高效文档解析工具 MinerU,以及思索式 AI 搜索应用 MindSearch 等在内的核心工具全面开源,已形成涵盖数十万开发者参与的活跃开源社区。

近期,上海 AI 实验室进一步开源了,可广泛应用于化学、物理、生物等领域的 12 种科研任务,在大幅提升科研效率的同时,亦初步展现出多智能体系统自主学习、持续进化的潜力,为人工智能自主完成算法设计、科学发现等高端科研任务开辟了全新探索路径。

基于 Intern-S1 的亦于近日上线,助力研究者、研究工具、研究对象三者能力全面提升、协同演进,驱动科学研究从团队单点探索迈向科学发现 Scaling Law 阶段。

未来,在研究范式创新及模型能力提升的基础上,上海 AI 实验室将推进 Intern-S1 及其全链条工具体系持续开源,支持免费商用,同时提供线上开放服务,与各界共同拥抱更广阔的开源生态,携手打造更懂科学的 AI 助手。

Intern-S1 实测

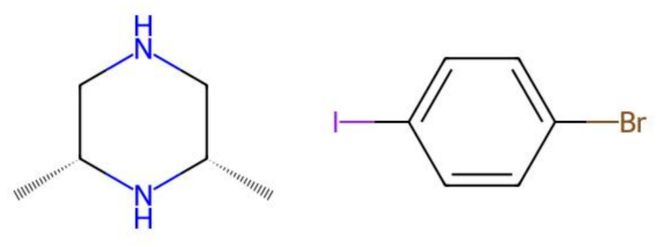

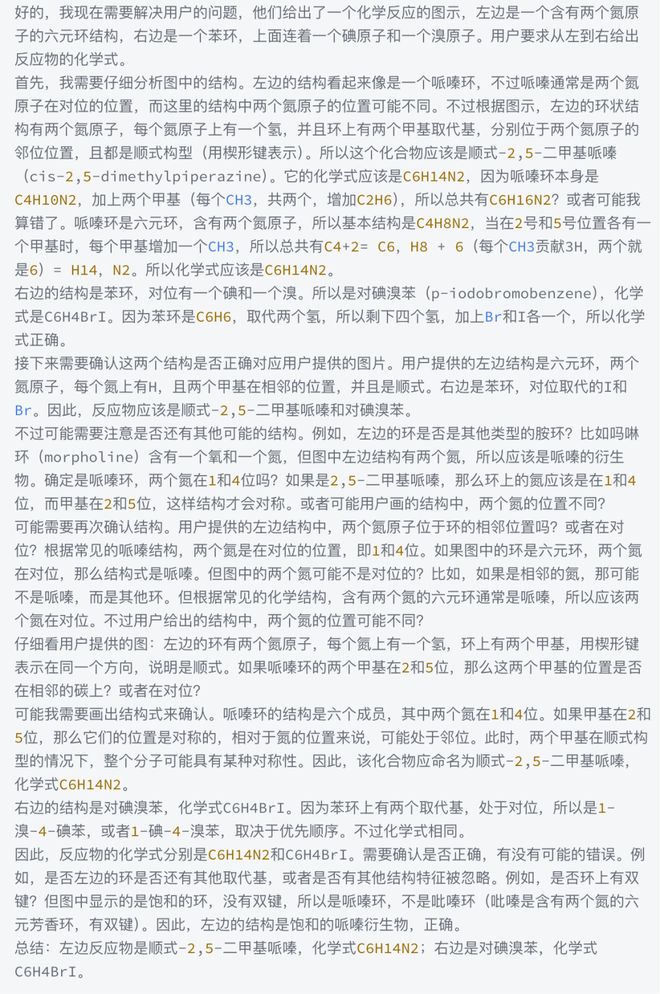

借助强大的多模态及科学能力,Intern-S1 面对科学问题时得心应手。下方案例,展示了 Intern-S1 快速、准确识别图中反应物的化学式。

Q:从左到右,给出图中反应物的化学式

Intern-S1:左边反应物是顺式-2,5-二甲基哌嗪,化学式为C₆H₁₄N₂;右边是对碘溴苯,化学式为C₆H₄BrI

作为对比,Grok 的答案:C5H11N, C6H4BrI(回答错误)

Intern-S1思考过程如下:

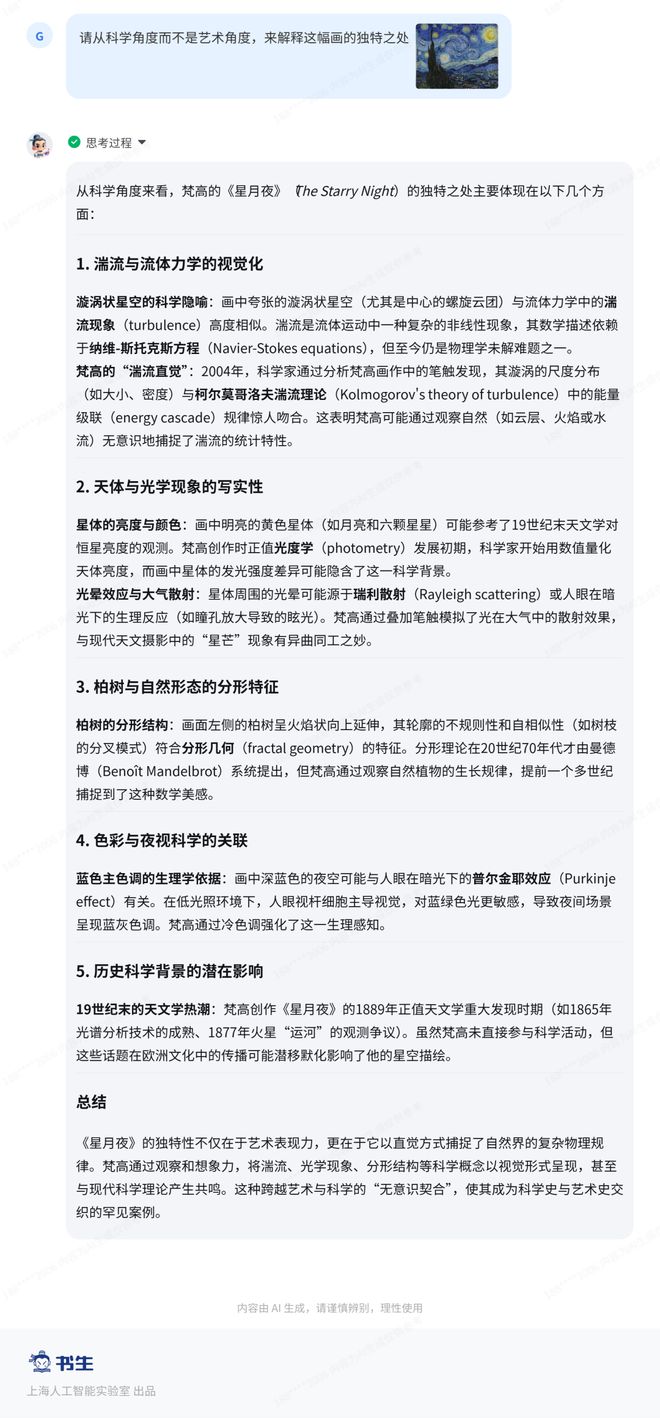

面对艺术作品时,Intern-S1 还能以科学的逻辑和知识体系对艺术画作进行理性赏析,以科学的方式「读懂」艺术。