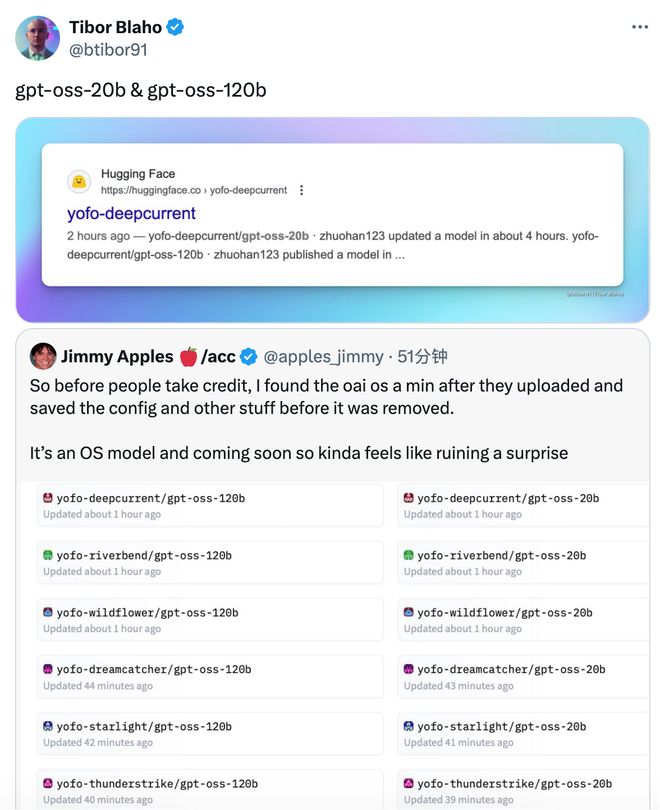

刚刚,OpenAI 开源模型疑似被手滑「泄露」?!

gpt-oss-20b 和 gpt-oss-120b!

网友@apples_jimmy 在这组模型上传 Hugging Face 后一分钟内就发现了。

99% 的概率这就是 OpenAI 的开源模型——

gpt 属于 OpenAI,oss 代表开源软件,20b 和 120b 代表了两个参数版本。

幸运的是,在它被删除之前,Jimmy Apples 保存了配置,在只有不到「1 分钟」的时间窗口!

他分享了一段 LLM 的配置文件,极有可能是 OpenAI 即将开源模型的详细参数。

这组参数像是一个基于 MoE(Mixture of Experts)混合专家架构的高容量模型,具备以下几个特点:

· 36 层 Transformer,每层可能有 MoE 路由;

· 大规模 MoE 设置(128 个专家,每个 token 激活 4 个);

· 词表超过 20 万,可能支持多语种或代码混合输入;

· 上下文窗口为 4096,但也有滑动窗口和扩展 RoPE,表明模型可能具备处理更长上下文的能力;

· 使用 RoPE 的 NTK 插值版本,这是许多模型扩展上下文的一种方式(如 GPT-4 Turbo 使用的方式);

· 注意力头多达 64 个,但键/值头只有 8 个,意味着模型用的是是 Multi-QueryAttention(MQA)。

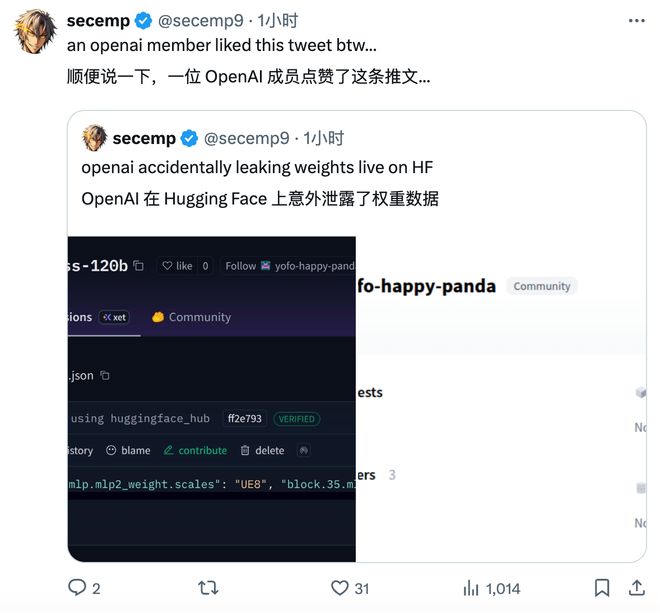

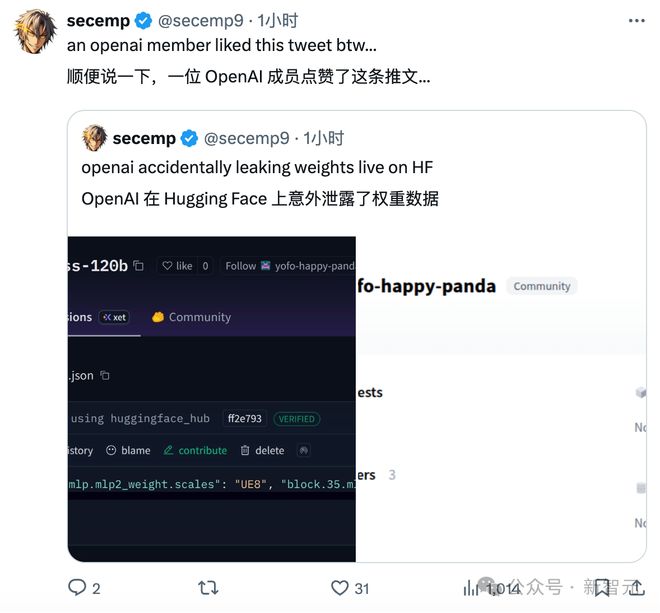

另一位网友@secemp9 似乎验证了这次「泄露」的真实性。

他不仅也在 Hugging Face 上发现这个模型,甚至还有一位 OpenAI 成员点赞了他的爆料推文。

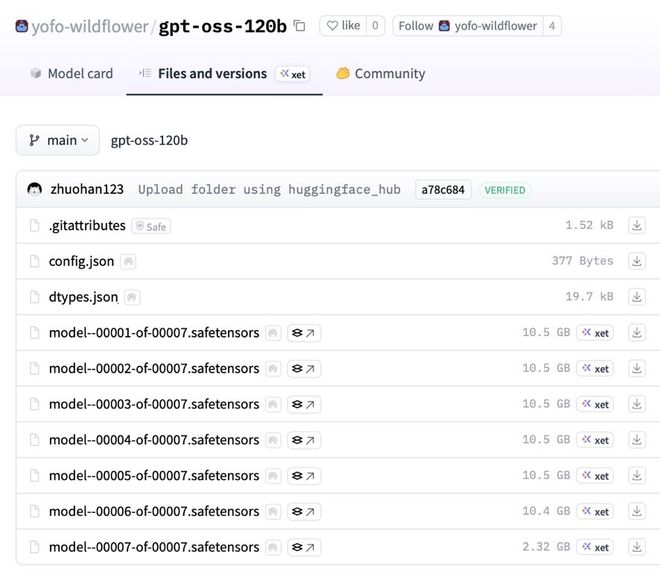

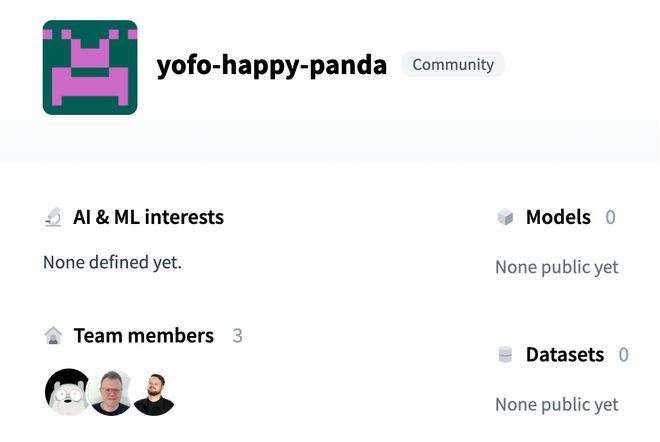

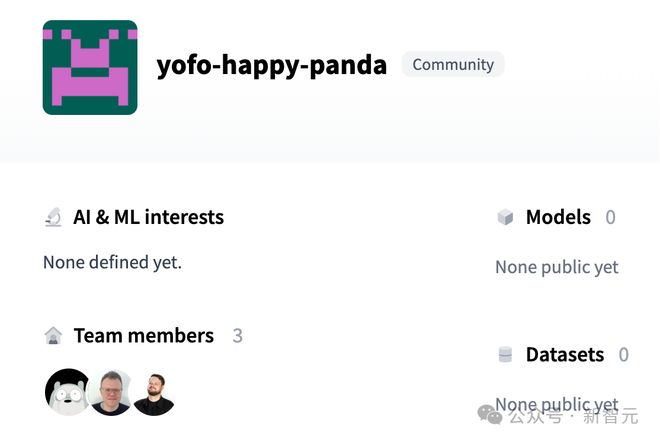

上传这个模型的组织叫做「yofo-happy-panda」,共有三名成员。

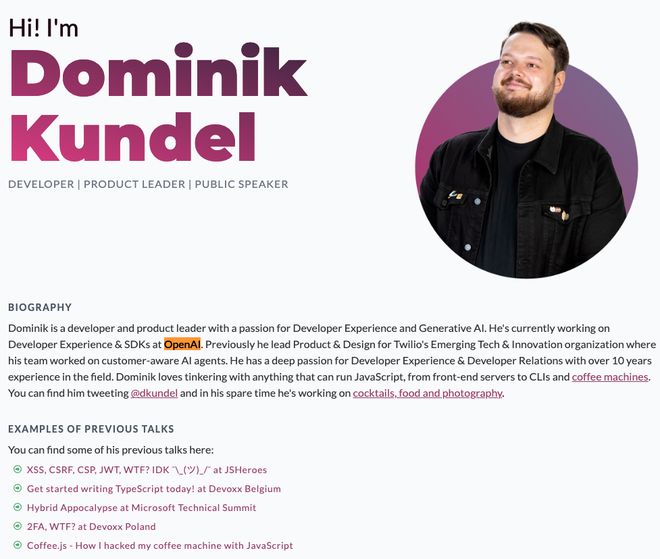

其中,Dominik Kundel 正是 OpenAI 的现任员工,目前负责开发者体验和 SDK。

有网友猜测,所谓的提前泄露,或许是 GPT-5 发布前的预热?

如果真是这样的参数配置,你满意吗?