微软研究院近日发布了 RenderFormer,这是一个纯机器学习的神经架构,旨在通过机器学习完全替代传统图形计算,实现全功能 3D 渲染,无需传统图形计算。

RenderFormer 整体架构如下:

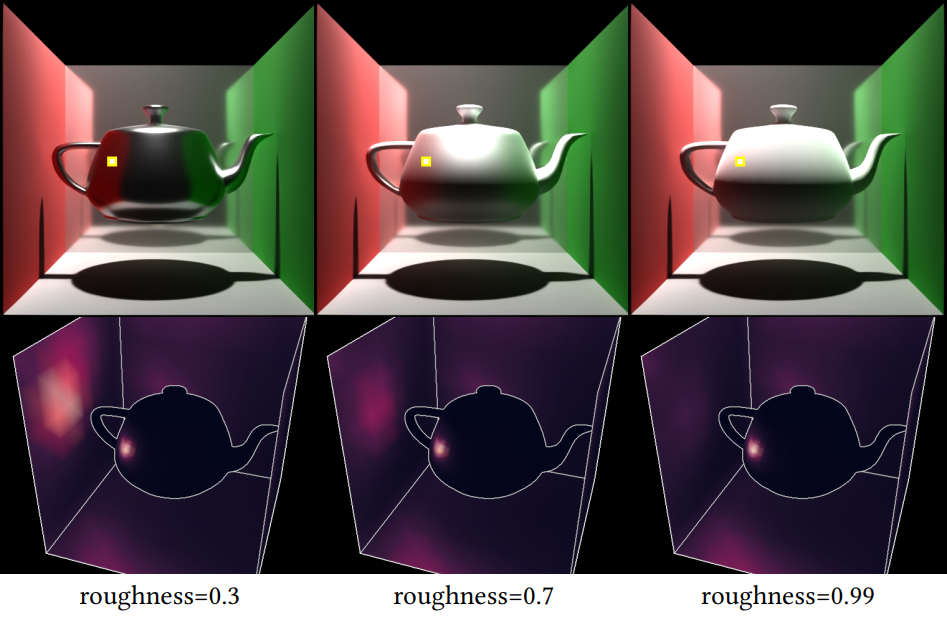

- 双分支 Transformer 架构:分为视角无关(View-Independent)和视角相关(View-Dependent)两个阶段。视角无关阶段通过自注意力机制捕捉阴影、漫反射等全局光照效果;视角相关阶段通过交叉注意力机制建模可见性、反射等视角依赖效果。

- 相对空间位置编码:创新性地采用改进的旋转位置编码(RoPE),基于三角形的 3D 空间位置而非序列索引,保持场景平移不变性。

据介绍,RenderFormer 是首个证明神经网络能学习完整图形渲染流水线的模型,支持任意 3D 场景和全局光照效果,无需依赖光线追踪或光栅化技术。它通过三角形令牌(triangle tokens)表示 3D 场景,编码空间位置、表面法线及材质属性,结合光线束令牌(ray bundle tokens)处理视角信息,实现端到端渲染。该成果已获 SIGGRAPH 2025 接收并开源。